En plena ola de adopción de modelos de lenguaje como ChatGPT, Gemini o Claude, un estudio reciente de la firma Incogni pone el foco sobre una dimensión que suele pasar desapercibida: la privacidad. Su informe, titulado «Gen AI and LLM Data Privacy Ranking 2025», analiza y compara nueve de los modelos más populares del mercado según once criterios agrupados en tres bloques clave: entrenamiento, transparencia y recolección-compartición de datos.

Quiénes protegen (y quiénes no) tus datos

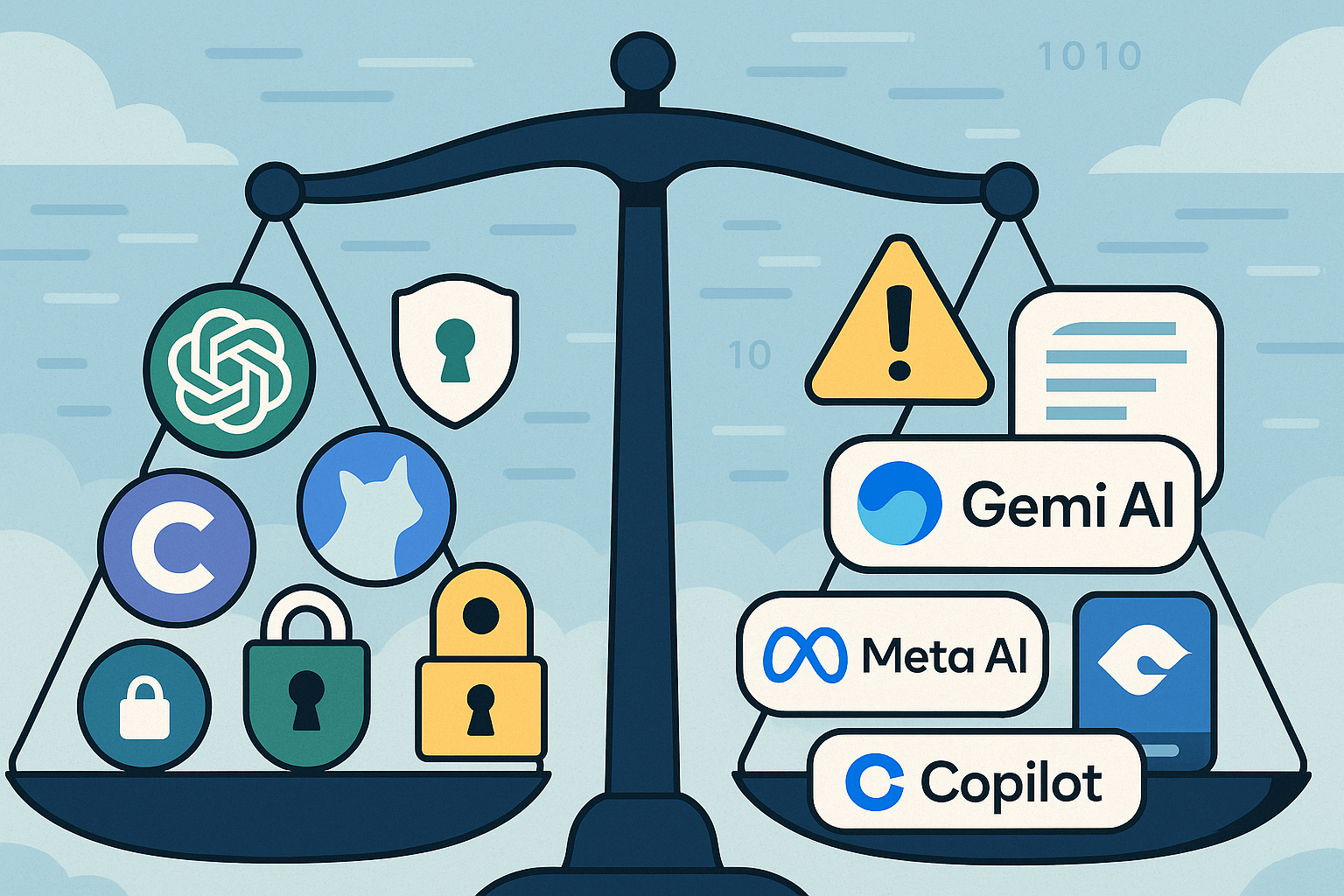

El resultado es revelador. Mientras algunos modelos recogen y reutilizan información personal de forma opaca, otros ofrecen mayor claridad y opciones de control. Gemini (Google), Meta AI y Copilot (Microsoft) aparecen como los menos respetuosos con la privacidad. No solo impiden que el usuario excluya sus datos del entrenamiento, sino que además recolectan información sensible como la ubicación o el número de teléfono. En contraste, Claude (Anthropic), ChatGPT (OpenAI), Le Chat (Mistral) y Grok (xAI) permiten limitar el uso de datos personales y explican sus políticas de forma accesible.

Políticas comprensibles vs. documentos opacos

El estudio también pone en evidencia diferencias en la transparencia. Claude y ChatGPT destacan por presentar sus condiciones de uso en lenguaje claro y accesible, mientras que Meta y Gemini esconden la información relevante entre largos documentos legales, dificultando al usuario conocer el destino de sus datos.

Compartición con terceros: una práctica extendida

Otra área sensible es la compartición de datos con terceros. Aunque todos los modelos recogen información al crear una cuenta o usar la app, algunos van más allá. Meta AI, por ejemplo, puede compartir nombres, correos y teléfonos con socios o instituciones de investigación. Gemini y DeepSeek también recopilan números de teléfono, mientras que Claude y Grok derivan algunas interacciones hacia servicios externos.

Recomendaciones para proteger tus datos

Ante este panorama, Incogni recomienda elegir modelos que funcionen como simples «procesadores», sin almacenar información de los usuarios, o bien utilizar versiones locales o en la nube privada, donde haya un mayor control sobre los datos. El consejo más práctico: no introduzcas en un modelo de IA nada que no dirías en una red social.

Más allá del rendimiento: la privacidad como criterio

En definitiva, el estudio de Incogni va más allá de la comparativa funcional. Lanza un mensaje claro: al elegir una inteligencia artificial, no solo importa su capacidad técnica, sino también su compromiso con la privacidad. En la era de los datos, lo que hacen los modelos con tu información importa tanto como lo que te ayudan a crear.