La IA no es solo una revolución tecnológica; es el nuevo campo de batalla geopolítico. Su desarrollo y regulación definirán el equilibrio de poder y el modelo de sociedad del siglo XXI. En esta encrucijada, Europa se encuentra ante un reto mayúsculo: ¿se posicionará como el garante de los derechos fundamentales en el ámbito digital, o cederá ante la inercia de otros modelos dominantes? Para descifrar esta compleja dinámica y dilucidar los retos y riesgos que la IA presenta, este artículo se apoya en las reflexiones de algunas de las voces más reputadas en el ámbito de la regulación, política y filosofía: la profesora Anu Bradford, quien acuñó el concepto «Efecto Bruselas»; Carme Artigas, copresidenta del Consejo Asesor de la ONU en IA; y el catedrático de filosofía política, Daniel Innerarity, quienes nos ofrecen claves para comprender la magnitud del desafío.

¿Qué modelos se encuentran en liza?

Anu Bradford identifica, al menos, tres modelos tecnológicos en pugna global:

El modelo europeo: Prioriza la regulación y la protección de derechos fundamentales. Su buque insignia es el Reglamento de IA, que no regula la IA o la tecnología en sí misma, sino determinados riesgos asociados a casos de uso (enfoque basado en el riesgo). Este enfoque busca crear un marco de confianza para que la ciudadanía y las empresas adopten la IA sin temor -o al menos con la seguridad de que un conjunto de garantías razonables es de obligado cumplimiento- a la manipulación, el fraude o la discriminación. El Reglamento de IA es la primera regulación horizontal de IA en el mundo, entró en vigor el 1 de agosto de 2024. Sin embargo, este modelo enfrenta presiones, internas y externas, que buscan debilitarlo.

El modelo estadounidense: Dominado por el mercado y las grandes tecnológicas, cuyo principal motor es el beneficio económico. Para Bradford, estas empresas «no se despiertan preguntándose qué pueden hacer por la democracia». El gobierno de EE. UU. tiende a alejarse de la conversación regulatoria global, apostando por una carrera desenfrenada hacia la supremacía, como evidencia la propuesta (y la fuerte oposición a ella) de una moratoria regulatoria federal de 10 años que buscaba evitar legislaciones estatales más restrictivas, que finalmente no prosperó. De hecho, en enero de 2025, la administración de Trump revocó la Orden Ejecutiva de Biden sobre el desarrollo y uso seguro y fiable de la IA, enfatizando la eliminación de «barreras regulatorias» para fomentar la innovación sin obstáculos. A pesar de la falta de una ley federal horizontal, existen numerosas leyes estatales de IA en EE.UU., el marco de gestión del riesgo del National Institution Standards and Technology (NIST) y agencias como la U.S. Copyright Office que son cada vez más activas en el desarrollo de orientaciones y marcos para proponer su visión sobre cómo regular la IA.

El modelo chino: Caracterizado por un autoritarismo digital que gana influencia, especialmente en países en desarrollo. China demuestra que «la libertad no es necesaria para la innovación», una afirmación que subraya el potencial de la tecnología para el control social –o la represión y el impacto en los derechos humanos-. Mientras Europa y EE. UU. debaten, China construye infraestructuras inteligentes a escala global, exportando su modelo junto con su tecnología: la nueva ruta de la seda digital. China aprobó normas que regulan la IA generativa o los algoritmos de recomendación en 2023. Estas regulaciones, promulgadas como «reglamentos administrativos», requieren, entre otras cosas, que los modelos de IA se registren en el «registro de algoritmos» de China, se realice una evaluación de seguridad antes de su lanzamiento, se etiquete el contenido generado por IA (un contenido que, en ningún caso, puede ser contrario al régimen del partido comunista) y se aseguren fuentes de datos de entrenamiento lícitas. El objetivo de China es alcanzar el «liderazgo global en IA» para 2030.

La tensión entre estos modelos es palpable. Como subraya Artigas, la IA es una «arma para la supremacía económica y militar«. La narrativa de que «la regulación frena la innovación» es, para ambas expertas, Artigas y Bradford, una falsa dicotomía. «Se puede crecer, innovar y proteger los derechos de los ciudadanos al mismo tiempo», afirma Bradford.

El verdadero peligro, según Artigas, es la erosión de la confianza social: la incapacidad de distinguir lo real de lo artificial, abriendo la puerta a la manipulación masiva. A lo que podemos añadir otras problemáticas de gran calado como la sicofancia, la deuda cognitiva o el sesgo de automatización y la aversión al algoritmo. De ahí la insistencia europea en la transparencia, demandando «algo-scores”, en la misma línea de las etiquetas nutricionales» de los alimentos, para los modelos de IA, una exigencia a la que la industria a menudo se resiste, lo que nos suscita la siguiente pregunta: ¿Qué ocultan?

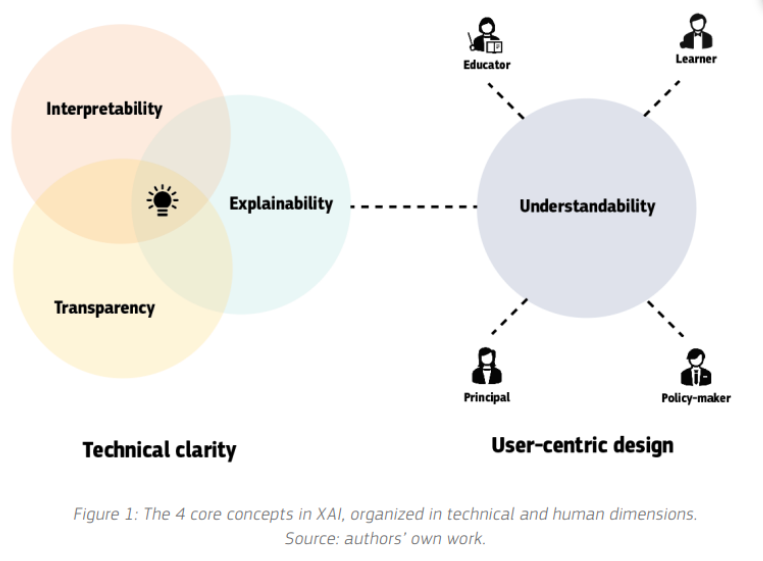

En este sentido y dotado de un magisterio descomunal, Daniel Innerarity problematiza la «transparencia» como panacea. Argumenta que la tecnología de IA presenta opacidades inherentes: (i) intencional (una deliberada voluntad de ocultar para proteger propiedad o privacidad); (ii) objetiva (asimetría de conocimiento entre expertos y el público); y (iii) emergente (la evolución impredecible del algoritmo al interactuar con el entorno). Esto lleva a la necesidad de «explicabilidad» o «interpretabilidad» -que la IA pueda explicarse a un nivel comprensible- y de instituciones públicas de supervisión o auditoría que generen confianza, descargando al individuo de la excesiva carga de responsabilidad de comprender cada detalle y caso de uso tecnológico.

Innerarity ahonda en esta preocupación, señalando que el problema fundamental de la IA es la creciente externalización de las decisiones humanas. La automatización masiva nos obliga a reevaluar el lugar de la decisión humana: ¿es un suplemento, una modificación o un reemplazo?

En otro orden de consideraciones, la batalla no sólo se libra por el control de la tecnología o por el trasvase decisional humano en algoritmos, sino que también se libra por los datos y la energía. La IA global depende del acceso masivo a ambos, lo que explica el resurgimiento de estrategias como la energía nuclear y la importancia de leyes como el Reglamento de Datos (Data Act), diseñada para proteger los datos industriales del continente. El consumo de energía de los centros de datos, cruciales para la IA, se ha triplicado en la última década y se espera que vuelva a triplicarse hasta 2028, superando el consumo anual de electricidad de países como España, Reino Unido o Italia.

¿Qué significa todo esto en la práctica?

Para Europa: Según lo que expone Bradford, la principal oportunidad es consolidar su mercado único digital, atraer talento global (aprovechando las políticas migratorias restrictivas de EE. UU.) y repensar las leyes de inversión y quiebra (insolvencia) para permitir mayor tolerancia al fracaso empresarial. A su vez, necesitamos invertir masivamente en Deep Tech (p. ej., la computación cuántica). Europa no tiene los gigantes tecnológicos de EE. UU. o China, por lo que su estrategia debe pasar por proponer una alternativa para su soberanía digital, así como resistir la «carrera a toda costa» y convencer a las Big Tech a adaptarse a los valores democráticos, no al revés. El Reglamento de IA es un pilar fundamental en esta estrategia, buscando generar confianza y un estándar de protección de los derechos fundamentales a nivel global. Innerarity añade que el modelo europeo de equilibrio es el camino correcto, defendiendo que la democracia puede y debe ser el marco para resolver los problemas de la humanidad, frente a soluciones tecnocráticas o autoritarias.

Para las empresas (especialmente PYMES): La IA generativa ofrece una oportunidad sin precedentes para la eficiencia operativa y la competencia global, eliminando las barreras del tamaño. La clave, según Carme Artigas, reside en identificar las tareas automatizables y apostar por el reskilling y upskilling de los empleados. Asimismo, la protección de los datos únicos de cada empresa será su mayor ventaja competitiva. Sin embargo, deben ser conscientes de los riesgos de la concentración de poder y la necesidad de una transición laboral justa, ya que la IA afectará, en primera instancia, a los puestos de trabajo de nivel medio y administrativo, impactando desproporcionadamente a los colectivos más vulnerables.

Para la sociedad y los legisladores: La IA plantea un profundo debate sobre el futuro del trabajo, la desigualdad y el propósito humano. Si bien la eficiencia es un beneficio, no debe traducirse en ineficiencia social a través de un desempleo masivo sin soluciones. La reducción de la jornada laboral o la renta básica universal son debates necesarios. El riesgo existencial no es un robot autónomo asesino, de nuevo, es la erosión de la confianza en una sociedad democrática fundamentada en el diálogo entre diferentes, el pluralismo, y la defensa de los derechos fundamentales. Ante quienes aducen que este destino de la IA es inevitable; Artigas expone: «el futuro no está escrito; lo escribimos cada día», instándonos a desplegar nuestra autonomía humana en esta transformación.

Como dijo Stephen Hawking: «El éxito en la creación de la IA podría ser el evento más grande en la historia de nuestra civilización. Pero también podría ser el último, a menos que aprendamos cómo evitar los riesgos». Entonces, la pregunta es: ¿estaremos como humanos a la altura de este reto?