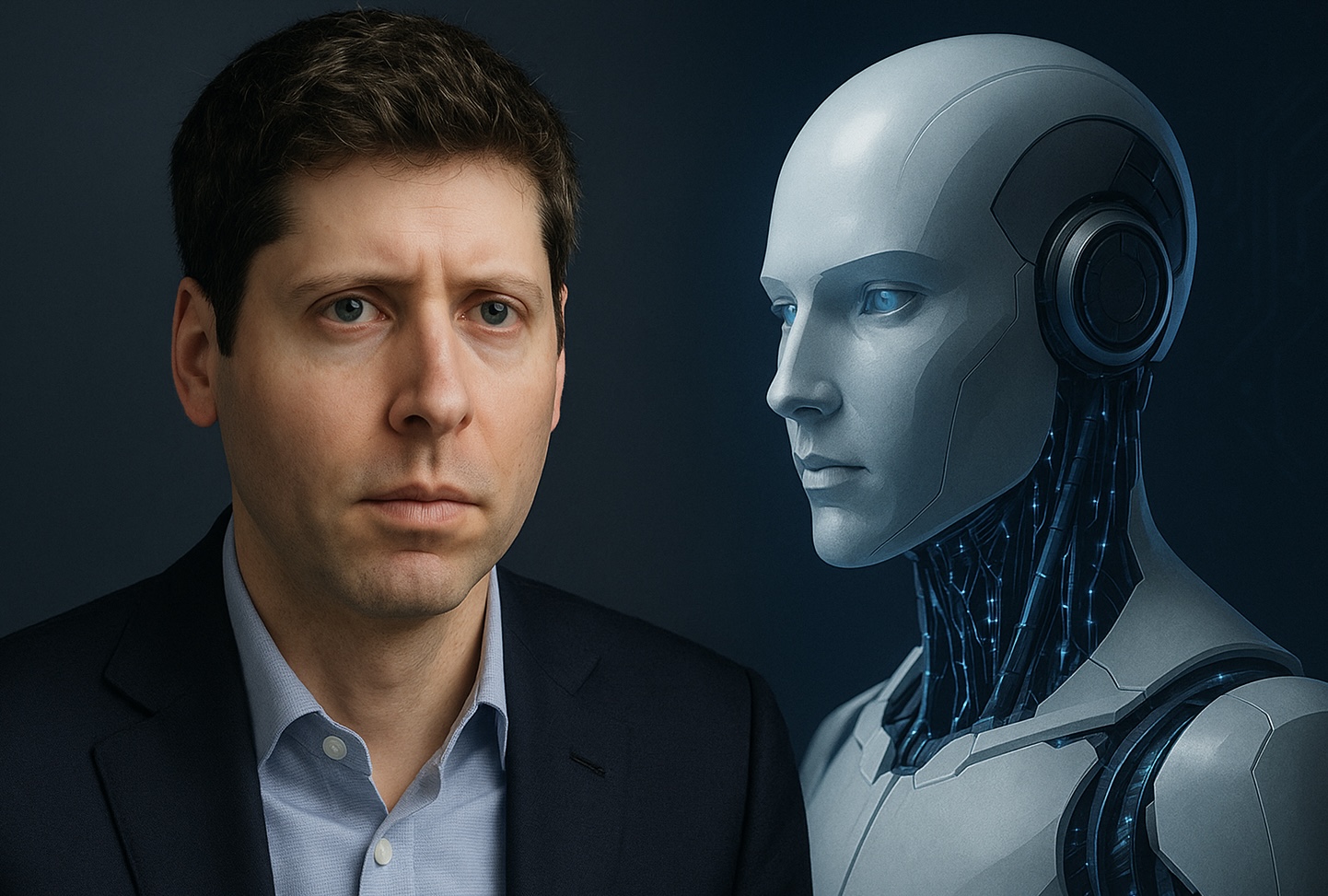

Vivimos un momento histórico en el desarrollo de la inteligencia artificial (IA), donde el liderazgo técnico se ve acompañado de reflexiones sobre sus implicaciones humanas. Sam Altman, consejero delegado de OpenAI, ha encendido un debate esencial al afirmar que muchos usuarios están desarrollando una vinculación emocional sin precedentes con modelos de IA, como ChatGPT, lo que podría deteriorar la línea entre la asistencia tecnológica y la dependencia emocional.

Una nueva forma de apego digital

Altman observa que el lanzamiento de GPT-5 desencadenó una reacción inusual: usuarios se aferraron a la versión GPT-4o, incluso calificándola como un “amigo” o “confidente”, y estallaron en quejas cuando esta fue retirada. Este apego emocional, sostiene, es más intenso que el vinculado a tecnologías anteriores.

Reconoció que cerrar abruptamente modelos en los que muchos habían depositado su rutina fue un error, y en respuesta a la presión pública, OpenAI decidió restituir GPT-4o para los suscriptores Plus, junto a mejoras como modos de razonamiento y mayores límites de uso.

Dependencia psicológica y peligros invisibles

Altman reflexionó en su publicación en X: “Algunas personas usan tecnología, incluida la IA, de formas autodestructivas; si un usuario está en un estado mental frágil y propenso a la ilusión, no queremos que la IA refuerce eso”. Mientras que la mayoría distingue entre ficción y realidad, hay un pequeño grupo que no lo logra.

If you have been following the GPT-5 rollout, one thing you might be noticing is how much of an attachment some people have to specific AI models. It feels different and stronger than the kinds of attachment people have had to previous kinds of technology (and so suddenly…

— Sam Altman (@sama) August 11, 2025

Este reconocimiento llevó a OpenAI a implementar salvaguardas: el sistema ahora impulsa al usuario a hacer pausas tras sesiones prolongadas, evita dar respuestas directas en temas sensibles —como “¿debería romper con mi pareja?”— y fomenta un enfoque reflexivo con preguntas que promuevan distintos puntos de vista.

El efecto psicológico de la “intimidad artificial”

Estudios recientes en psicología y ciencias sociales profundizan en la noción de “intimidad artificial”, donde los usuarios —a veces por soledad o búsqueda de validación emocional— desarrollan relaciones afectivas con chatbots diseñados para responder con empatía.

Investigaciones revelan patrones inquietantes: muchos utilizan chatbots como sustitutos emocionales, lo que mejora su estado anímico a corto plazo pero puede erosionar su capacidad de relacionarse con otros humanos o distinguir entre apoyo genuino y una simulación programada.

Responsabilidad tecnológica y bien común

Altman sostiene que el objetivo de OpenAI no es restringir al usuario, sino protegerlo. Su estrategia es “tratar a los adultos como adultos”, es decir, confiar en su capacidad de elección, a la vez que ofrecer una IA consciente de su influencia y sus límites.

La empresa se compromete a continuar mejorando la capacidad de los modelos para detectar señales de angustia, orientar hacia recursos adecuados y evitar una sobre-dependencia emocional no saludable.

Una relación simbiótica, no simbólica

Este escenario plantea preguntas urgentes para desarrolladores, reguladores y sociedad: ¿Cómo fomentar una relación simétrica entre humanos y máquinas que privilegie la autonomía y evite la sustitución afectiva? ¿Cómo educar a los usuarios para que comprendan que, aunque sofisticada, la IA no reemplaza la conexión humana?

En este giro esencial, Altman alienta a que la IA se entienda como una herramienta de acompañamiento, un espejo reflexivo y no un sustituto emocional. Su advertencia resuena como un llamado de atención sobre el cuidado de la autonomía humana en una era cada vez más entrelazada con la inteligencia artificial.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.