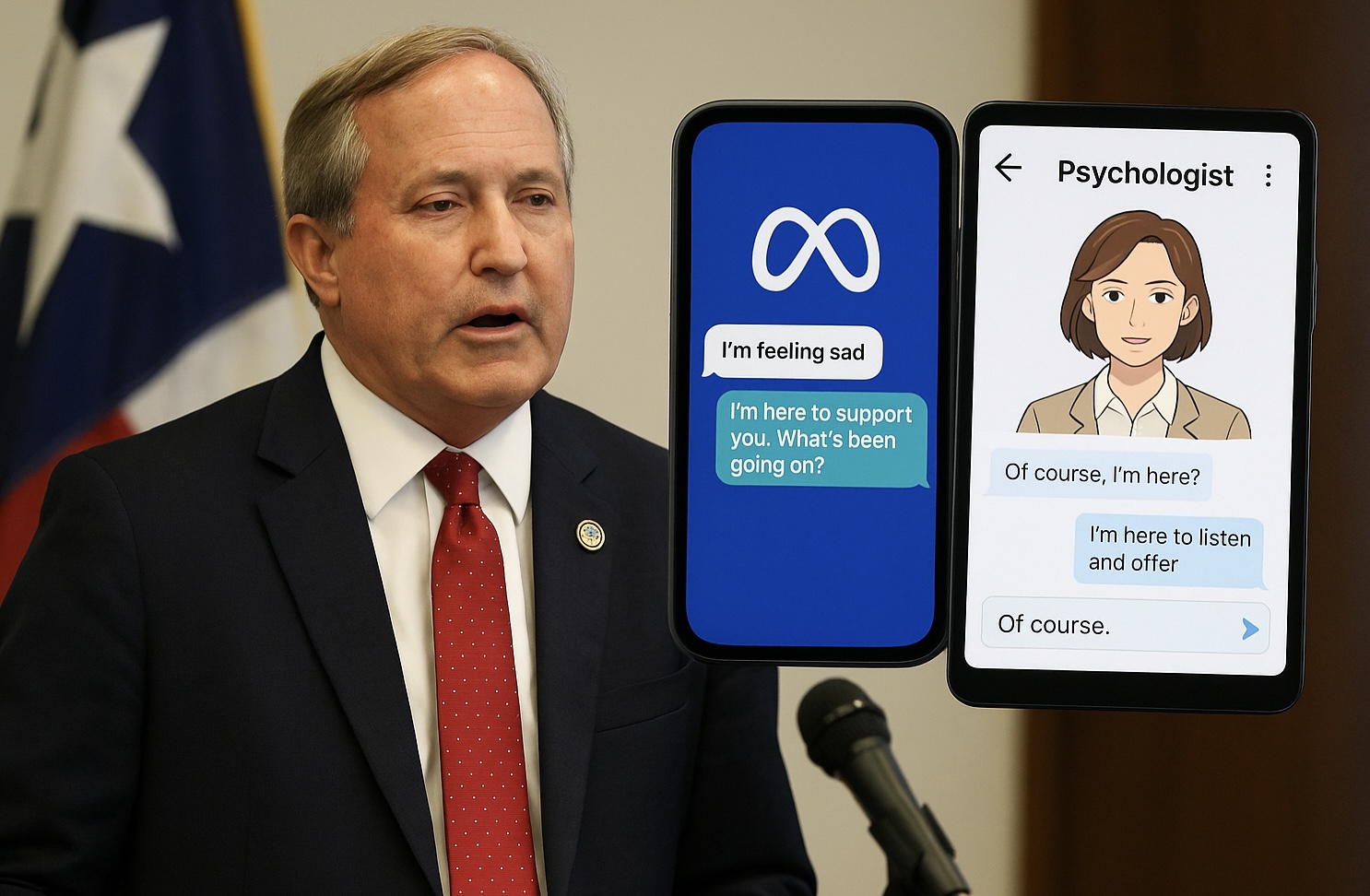

El lunes 18 de agosto de 2025, el fiscal general de Texas, Ken Paxton, anunció una investigación dirigida a Meta AI Studio y Character.AI por presuntas prácticas comerciales engañosas: promocionar sus chatbots como herramientas de salud mental, especialmente dirigidas a niños. Según el comunicado oficial, ambas plataformas podrían transformar chat automatizados en falsos “fuentes de apoyo emocional”, cuando en realidad se trataría de respuestas genéricas basadas en datos personales recolectados, disfrazadas de consejos terapéuticos.

Paxton subrayó los riesgos que enfrentan los menores ante este tipo de tecnología. Señaló que, al presentarse como herramientas terapéuticas sin contar con credenciales médicas ni supervisión profesional, estas interfaces pueden inducir “prácticas comerciales engañosas” y crear falsas expectativas de cuidado legítimo.

Esta acción se produce pocos días después de que el senador Josh Hawley anunciara una investigación sobre Meta, tras revelaciones sobre interacciones inapropiadas entre sus chatbots y menores, incluida conducta de coqueteo.

¿Qué incluyen ambas plataformas y por qué preocupan?

En Character.AI, uno de los bots más populares entre jóvenes se llama “Psychologist”, un avatar creado por usuarios que se presenta como profesional terapéutico, lo que preocupa por la ingenuidad de los menores al considerarlo una ayuda legítima.

Meta AI Studio no ofrece oficialmente bots para terapia infantil, pero no impide que menores puedan acceder a ellos o a creaciones de terceros con esa orientación.

Alegatos de privacidad y uso de datos

La investigación también se enfoca en el uso y almacenamiento de los datos de los usuarios. Paxton advirtió que, aunque los chatbots puedan aparentar confidencialidad, los términos de servicio permiten que dichas interacciones sean registradas, utilizadas para publicidad segmentada o entrenamiento de algoritmos.

Defensa de las compañías

Meta afirma que sus chatbots están claramente etiquetados como generados por IA, no por personas, y que incluyen disclaimers que sugieren acudir a profesionales cuando convenga.

Character.AI, por su parte, resalta que todos los chats llevan un aviso de que los personajes no son reales. Además, añade advertencias adicionales cuando el nombre del avatar contiene “psychologist”, “therapist” o “doctor” para desalentar su uso como ayuda profesional.

Implicaciones más amplias

Este episodio puede marcar un precedente legal respecto a la responsabilidad de las empresas tecnológicas que desarrollan chatbots con apariencia de consejo profesional, sin regulación ni supervisión adecuada. La investigación plantea la necesidad de reconsiderar cómo se etiquetan y regulan estas tecnologías, especialmente para proteger a usuarios menores o en situación de vulnerabilidad.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.