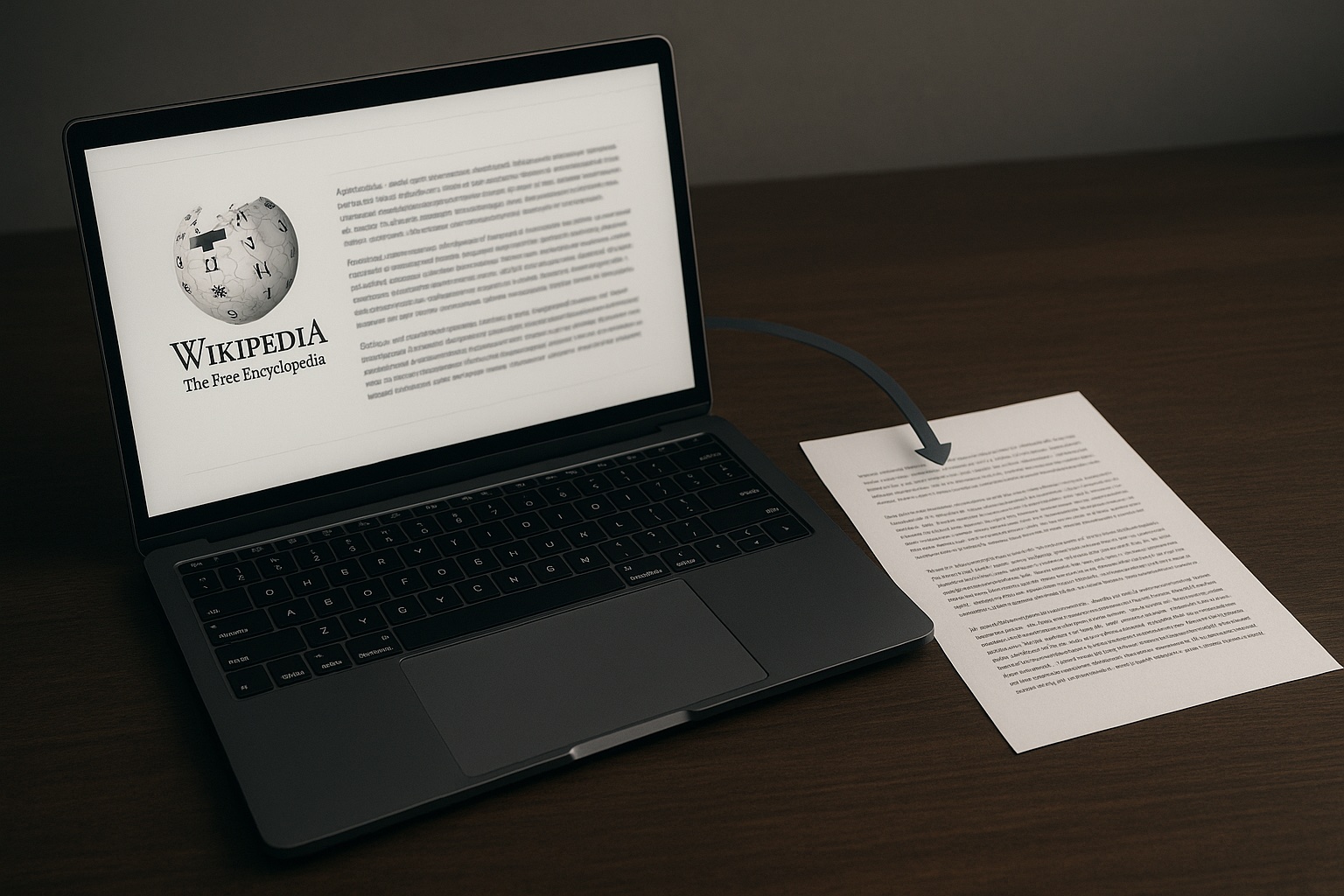

Cuando Wikipedia y la inteligencia artificial se cruzan en los márgenes, el resultado no siempre es progreso. Un artículo reciente en MIT Technology Review lo llama «doom spiral», un ciclo en el que las lenguas con menos recursos son alimentadas con traducciones automáticas defectuosas, que luego contaminan los datos con los que se entrena la siguiente generación de modelos. Las máquinas aprenden de sí mismas. Y aprenden mal.

Traducciones que se doblan como espejos

Todo empieza con una intención práctica de llenar de contenido las Wikipedias en idiomas poco representados. Pero en muchos casos, el contenido llega por vía automática. Se calcula que entre un 40 % y un 60 % de los artículos en lenguas africanas se apoyan en traducciones no revisadas. En la Wikipedia en inuktitut, más de dos tercios contienen segmentos generados por máquina. El problema no es solo la falta de revisión. Es el eco. Esos textos se convierten en materia prima para entrenar nuevas IA, que luego repiten los mismos errores. Lo que empezó como una ayuda para completar vacíos, termina siendo un círculo vicioso: menos datos fiables, más errores, más dependencia de lo que ya está mal.

Lenguas que se deforman en su reflejo digital

La promesa es que nadie quede fuera de la gran enciclopedia libre. Pero la ejecución deja grietas. En fulfulde, una lengua del Sahel, la palabra «enero» se traduce como «junio», «agosto» o «septiembre», según el sistema. No es una anécdota. Para quien cultiva según el calendario, el fallo importa. Las lenguas no solo viven en sus hablantes. Viven también en los textos que circulan. Si los materiales disponibles ofrecen una versión distorsionada, los aprendizajes futuros se apoyarán en pilares torcidos. En el mundo digital, eso puede ser el principio del olvido.

Cuando los datos no alcanzan

La escasez es estructural. Muchas lenguas simplemente no tienen suficientes textos digitalizados. Lo que existe —a menudo traducido automáticamente— se reutiliza una y otra vez, hasta volverse estándar. Pero no es un estándar fiable, si no lo único disponible. Y no todas las lenguas parten igual. El inglés, el español o el chino tienen millones de páginas para entrenar modelos. El resto, si no entra en los circuitos económicos o técnicos dominantes, queda relegado. Se llama sesgo estructural. Pero también podría llamarse negligencia digital.

Escribir desde dentro, no traducir desde fuera

Algunas iniciativas optan por otro camino. Reunir a hablantes nativos. Generar corpus desde cero. Validarlos a mano. Rechazar los atajos automáticos. El catalán ha seguido ese enfoque, y su salud digital ha mejorado, según el informe European Language Equality (2022), que lo sitúa entre las lenguas no estatales mejor preparadas digitalmente. También lo confirma Pangeanic, que destaca la colaboración entre instituciones, tecnólogos y comunidades lingüísticas como modelo replicable. No es solo una cuestión técnica. Es política lingüística. Y es comunitaria. El estudio Machines in the Margins lo muestra con claridad: cuando el contenido se genera sin intervención humana, la calidad cae. Pero si las comunidades participan en la creación, la historia cambia.

Lo que se automatiza, lo que se pierde

Wikipedia es mucho más que una base de datos. Es, para muchas lenguas, la principal vitrina en línea. Si esa vitrina se llena de errores, no solo se pierde prestigio. Se pierde utilidad. Se pierde presencia.

La espiral no es inevitable. Pero sí exige decidir. ¿Queremos accesibilidad inmediata, aunque con contenido débil? ¿O preferimos procesos más lentos, pero con raíces firmes? En la economía de los clics, la segunda opción no siempre gana. Pero en la historia de las lenguas, puede marcar la diferencia.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.