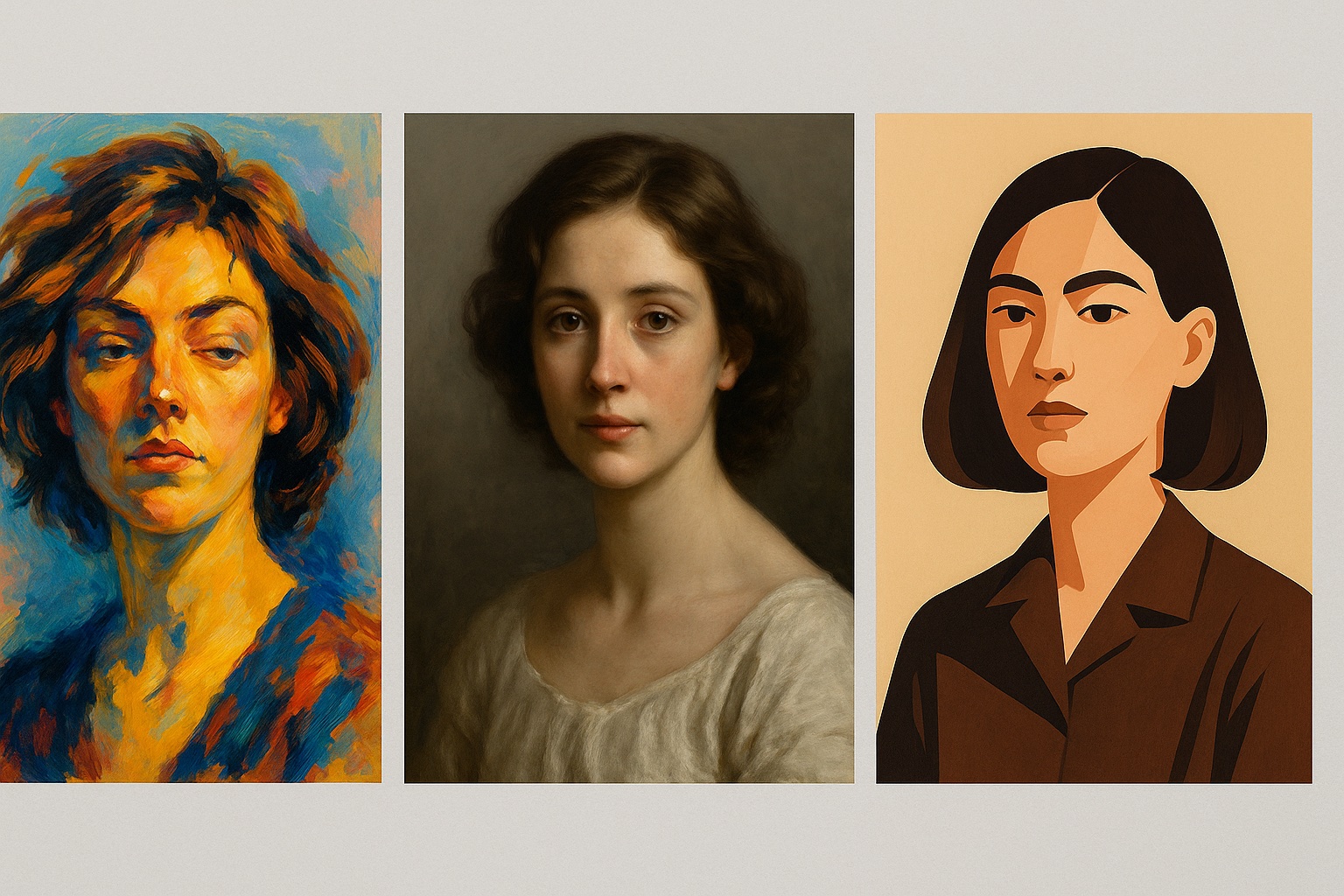

Tres modelos distintos, un solo pincel. Photoshop beta multiplica sus cerebros generativos y permite, por primera vez, elegir entre motores con estéticas y comportamientos propios. A Firefly se le suman ahora Gemini 2.5 (Nano Banana) y FLUX.1 Kontext. Más posibilidades, más preguntas. Sobre cómo se entrenan. Sobre cuál conviene. Sobre cuándo conviene. Y sobre qué implica delegar el trazo a una inteligencia que también interpreta.

Una imagen, tres formas de imaginar

Generative Fill transforma selecciones con palabras. Se selecciona un fragmento. Se escribe una instrucción. Se espera a que el modelo imagine. Hasta hace poco, el único que lo hacía era Firefly. Ahora hay tres. Y cada uno tiene su lógica, su sesgo, su manera de completar el mundo.

- Gemini 2.5 (Nano Banana), de Google, es el más atrevido. Prefiere el impacto al detalle, la textura al encaje. Tiende al gesto amplio, al trazo imaginativo, al color que no imita sino propone.

- FLUX.1 Kontext [pro], en cambio, se detiene. Lee la imagen como un plano. Analiza luz, profundidad, coherencia ambiental. Es el que mejor se adapta al conjunto, sin dejar huellas.

- Firefly, el modelo de Adobe, sigue siendo el más equilibrado. Permite controlar estilos, ofrece múltiples versiones, garantiza licencia comercial. Es el único que asegura lo que genera.

El usuario puede alternar entre ellos desde una barra contextual. Tres modelos para una sola acción. Tres intenciones distintas para una misma escena.

Elegir modelo: una decisión técnica, pero también narrativa

No es solo una cuestión estética. Cambiar de modelo implica aceptar distintas condiciones. Todos consumen créditos generativos, aunque en esta fase beta el uso es abierto. Pero solo Firefly garantiza cobertura legal para uso comercial. Los otros dos, de momento, no. Hay más diferencias: Firefly devuelve varias imágenes por prompt. Gemini y FLUX.1, solo una. Menos margen de prueba. Más peso sobre cada intento. La herramienta sigue siendo una, pero las reglas del juego cambian según el motor. Y esa elección ya no es solo técnica. Es estratégica. Y narrativa.

Entre libertad y traza: lo que se juega en cada clic

Con más modelos, crecen también las preguntas: ¿Cómo se entrenó cada uno? ¿Qué imágenes lo formaron? ¿Puede usarse una imagen generada con Gemini en una campaña publicitaria? ¿Qué ocurre si combino elementos de distintos modelos en una misma imagen? Adobe lo deja claro: esta versión es experimental. No todo lo que se genera es apto para producción. Pero todo está disponible para probarse. Y cada prueba activa una decisión que antes no existía.

De suite cerrada a campo abierto

Hasta ahora, Photoshop funcionaba con una sola IA. Una mirada única, controlada, alineada con el resto del ecosistema Adobe. Con esta apertura, se ensaya otra lógica. La de un espacio modular, donde distintos modelos coexisten. Y donde el usuario elige con cuál imaginar. TechRadar y Capture Magazine interpretan este movimiento como un giro estratégico. No se trata de sustituir Firefly, sino de abrirle competencia. Crear un tablero donde cada modelo ofrece una vía, un lenguaje, una promesa.

Una elección a plena vista

Photoshop ya no solo pregunta qué quieres ver. También con qué lente lo quieres mirar. Con qué inteligencia lo vas a generar. Y qué vas a hacer con lo que aparezca. Lo que antes era automático, ahora es una elección. Visible. Y como toda elección, tiene consecuencias.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.