Hasta ahora, para reportar un coche detenido o un atasco en Waze exigía dejar el volante, detener la mirada, buscar el icono correcto y confirmar. Ahora, la app quiere que el conductor simplemente lo diga en voz alta. “Hay algo en la carretera”, “Tráfico intenso”, “Vehículo parado”. Suena cotidiano, pero detrás se esconde una pieza más del gran experimento de Google por hacer que la tecnología entienda cómo hablamos —y no al revés—.

La voz como nuevo gesto

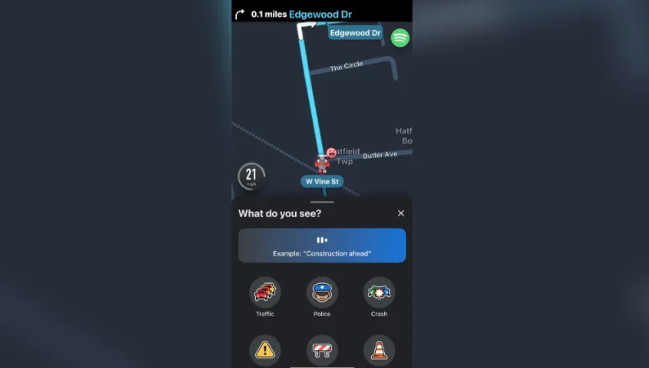

La función Conversational Reporting, llega un año después de ser anunciado (hasta ahora solo estaba en fase beta), se activa con un toque y una frase. Nada de menús ni botones pequeños. Si el mensaje es claro, el sistema lo traduce al instante en una alerta visible para otros conductores; si duda, responde con naturalidad: “¿Puedes describir lo que ves?”. El copiloto invisible que sugiere Waze está impulsado por Gemini, el modelo de lenguaje de Google capaz de captar contexto y tono. Es, en el fondo, una conversación disfrazada de informe, el conductor habla como lo haría con un pasajero y la máquina escucha, interpreta y actúa.

Menos taps, más atención

Waze lo presenta como un avance en seguridad. Cada gesto eliminado cuenta. Menos pantallazos, menos distracción. La función permite reportar sin apartar la vista de la carretera, y cada aviso se incorpora de inmediato al mapa, donde otros pueden anticiparse al obstáculo.

La novedad llega, además, en paralelo a la retirada de Google Assistant en Waze para iPhone, tras meses de fallos. Gemini toma el relevo. En Android, ambos conviven, de momento, como dos copilotos que aún se reparten el volante.

Lo que ocurre entre voz y nube

Detrás de ese gesto sencillo hay una cadena compleja. La voz se envía a la nube, donde Gemini analiza lo dicho, identifica entidades (“atasco”, “vehículo detenido”, “objeto en la vía”) y genera el aviso. El punto exacto del incidente se marca cuando el conductor inicia el reporte, no cuando termina de hablar. Una precisión mínima que evita confusiones, pero que revela hasta qué punto Waze se construye en segundos y coordenadas. En los ajustes, bajo “Voz y sonido”, puede activarse o silenciarse la función. Al hacerlo, aparece un pequeño icono animado, la señal de que la app está, literalmente, escuchando.

Tropiezos en la primera curva

Las primeras pruebas han traído también su ruido. Algunos usuarios de la comunidad beta en foros de Waze aseguran que el aviso de activación reaparece aunque se haya configurado, que la música se corta al hablar y no siempre vuelve. En CarPlay, la compatibilidad es aún parcial. Y, por ahora, solo entiende inglés.

Nada inusual para una beta, pero suficiente para que el entusiasmo inicial se frene un poco. Aun así, Waze mantiene su esencia: una comunidad que no solo comparte caminos, sino que empieza a conversar con ellos.

El espejo de la competencia

Google Maps ha introducido formas más simples de reportar incidentes, aunque ninguna tan conversacional. Apple Maps, por su parte, sigue sin ofrecer un sistema comunitario equivalente. En ese terreno, Waze conserva su identidad más viva:,el mapa coral que se construye palabra a palabra, aviso a aviso.

Un copiloto que aprende a escuchar

El verdadero salto no es técnico, sino cultural. Waze busca que la relación con la app deje de ser una secuencia de toques y pantallas para convertirse en una interacción más orgánica. Pero el desafío está en lo invisible, en lograr que esa voz reconozca todos los acentos, todas las formas de describir un bache o un coche parado.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.