La astronomía ha entrado en una era de descubrimientos sin precedentes,

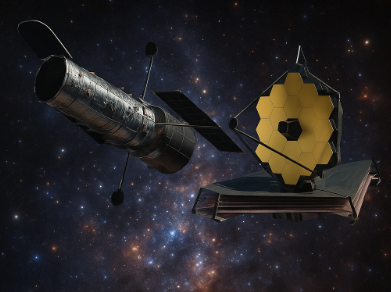

impulsada por observatorios espaciales de una sofisticación tecnológica cada vez mayor. Sin embargo, este progreso ha traído consigo un desafío monumental: un diluvio de datos de un volumen, velocidad y complejidad que desborda por completo los métodos de análisis tradicionales. El Telescopio Espacial James Webb (JWST), lanzado el 25 de diciembre de 2021, y su icónico predecesor, el Telescopio Espacial Hubble (HST), son los principales artífices de esta revolución, pero también la fuente de este torrente de información.

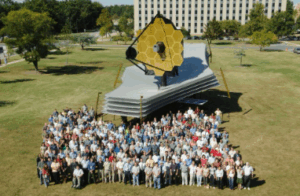

Primer modelo a gran escala del telescopio James Wevbb. Centro de vuelo espacial Goddard de la NASA (2005)By NASA/Goddard Space Flight Center/Pat Izzo – [1], Dominio público, https://commons.wikimedia.org/w/index.php?curid=7793655

La gestión y explotación científica de estos vastos archivos de datos se ha convertido en uno de los principales cuellos de botella para el avance del conocimiento. En este contexto, la Inteligencia Artificial (IA), y en particular las técnicas de aprendizaje automático (machine learning) y aprendizaje profundo (deep learning), han emergido no como una mera herramienta auxiliar, sino como una tecnología habilitadora indispensable, transformando radicalmente la forma en que detectamos, clasificamos y comprendemos los fenómenos cósmicos.

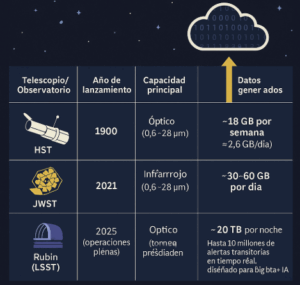

Webb vs. Hubble: La Explosión de Datos que Exige una Nueva Ciencia.

El salto cuantitativo y cualitativo en la generación de datos entre el Hubble y el Webb subraya la urgencia de esta transición tecnológica. El JWST, con su espejo primario de 6.5 metros y su optimización para el espectro infrarrojo, está diseñado para observar el universo primigenio, las atmósferas de exoplanetas y las regiones de formación estelar ocultas por el polvo. Esta capacidad superior se traduce en un volumen de datos diario de aproximadamente 29-30 GB, una cifra que empequeñece los ya considerables 2,6 GB diarios generados por el Hubble.

Este aumento no supone únicamente un reto de almacenamiento, sino una escalada en la complejidad de la información. Los datos del JWST ofrecen una sensibilidad hasta ~100 veces superior a la del Hubble en el infrarrojo cercano y medio, permitiendo detectar fuentes mucho más débiles. Aunque su resolución angular depende de la longitud de onda observada, el telescopio logra imágenes comparables o mejores que Hubble en varios rangos. Además, sus modos de espectroscopía multiobjeto e integral de campo producen conjuntos de datos multidimensionales de alta complejidad.

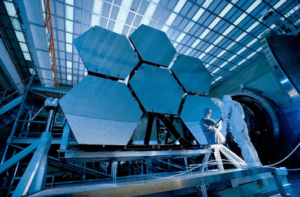

Pruebas criogénicas de los espejos del James Webb. NASA/MSFC/David Higginbotham/Emmett Given –http://www.jwst.nasa.gov/images_mirror45.html

Con la puesta en marcha de los grandes observatorios espaciales, la comunidad científica se enfrenta a una paradoja: poseer los instrumentos más potentes de la historia pero carecer de la capacidad humana para analizar la totalidad de sus observaciones. La inspección manual de millones de imágenes de galaxias o la búsqueda de sutiles señales de tránsito en las curvas de luz de cientos de miles de estrellas es una tarea intratable en escalas de tiempo razonables. Como advirtieron los planificadores de la misión JWST, la inactividad de un telescopio de 10 mil millones de dólares por no poder procesar sus datos es un mal escenario, subrayando la presión económica y científica para maximizar su rendimiento. La Inteligencia Artificial como Analista Cósmico. Clasificación Morfológica Automatizada de Galaxias.Es en este punto donde la IA se vuelve fundamental. Los algoritmos de aprendizaje automático están diseñados específicamente para identificar patrones sutiles y complejos en conjuntos de datos masivos y de alta dimensionalidad, tareas en las que superan con creces las capacidades humanas. La aplicación de estas técnicas ya no es una opción, sino una necesidad imperativa para traducir el torrente de bits que fluye desde el espacio en descubrimientos científicos significativos.

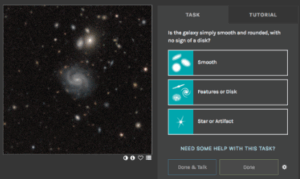

La imagen de la interfaz de clasificación del proyecto de ciencia ciudadana Galaxy Zoo. Se trata de una iniciativa que invita a voluntarios de todo el mundo a colaborar en la clasificación morfológica de galaxias.

La clasificación de galaxias según su morfología es una de las tareas más fundamentales de la astrofísica extragaláctica. Con la llegada de grandes sondeos como el Sloan Digital Sky Survey (SDSS) y las observaciones de campo profundo del Hubble, el número de galaxias detectadas se disparó a millones, haciendo que la clasificación manual por parte de astrónomos expertos fuera una tarea logísticamente imposible. Para superar este desafío, en 2007 se lanzó el proyecto Galaxy Zoo, una iniciativa de ciencia ciudadana que invitó al público general a clasificar imágenes de galaxias. El éxito fue abrumador, con más de 150,000 voluntarios contribuyendo con más de 50 millones de clasificaciones en su primer año. Este vasto corpus de imágenes con etiquetas morfológicas fiables se convirtió en el combustible que impulsó el desarrollo de algoritmos de aprendizaje automático, en particular, las Redes Neuronales Convolucionales (CNNs), para automatizar la tarea. Los resultados fueron espectaculares, con modelos que alcanzaban precisiones superiores al 97-99% en la distinción entre las clases morfológicas principales.

El éxito del proyecto Galaxy Zoo no solo resolvió un problema de clasificación masiva, sino que estableció un modelo de colaboración fundamental para la astronomía moderna: la inteligencia humana a gran escala entrena a la inteligencia artificial, que luego automatiza el descubrimiento a una velocidad inalcanzable.

Este es precisamente el enfoque que ahora se aplica a los datos del Hubble y, de forma aún más crucial, a los del James Webb para automatizar la clasificación de galaxias, acelerar la detección y caracterización de exoplanetas, y descubrir fenómenos cósmicos raros y transitorios que de otro modo permanecerían ocultos en el ruido.

Implicaciones Amplias y Contexto Futuro.

El desafío de los datos que plantean el Hubble y el Webb es solo el preludio. Una nueva generación de observatorios multiplicará en varios órdenes de magnitud el volumen y la complejidad de la información astronómica, haciendo que la inteligencia artificial deje de ser un apoyo para convertirse en el núcleo mismo del descubrimiento. El Observatorio Vera C. Rubin, cuyo inicio de operaciones a gran escala está previsto para 2025, escaneará el cielo austral completo cada pocas noches, generando en promedio 20 terabytes diarios y hasta 10 millones de alertas de eventos transitorios en tiempo real. Prepararse para este tsunami de datos exige abandonar la lógica de modelos aislados y avanzar hacia un ecosistema federado y distribuido de sistemas de IA, capaz de filtrar, clasificar y correlacionar la información en tiempo real.

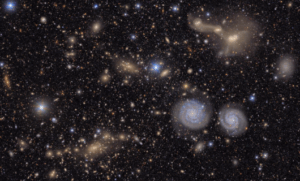

Sección de la vista completa del cúmulo Virgo tomada por el Observatorio Vera C. Rubin de la NSF-DOE. Se pueden ver dos galaxias espirales prominentes (abajo a la derecha), tres galaxias en proceso de fusión (arriba a la derecha), varios grupos de galaxias lejanas, muchas estrellas de la Vía Láctea y mucho más. Imgen y comentario de la revista del Instituto de Astrofísica de Canarias. Crédito: NSF-DOE Vera C. Rubin Observatory

El tsunami de datos astronómicos: de Hubble a Rubin. De gigabytes a terabytes por día: la astronomía entra en la era del big data extremo, donde la IA es la única vía para transformar torrentes de datos en descubrimiento científico.

El Futuro Simbiótico de la Inteligencia Humana y de Máquina en la Astronomía.

El análisis exhaustivo de la aplicación de la inteligencia artificial a los datos de los telescopios espaciales Hubble y James Webb revela una transformación fundamental en la práctica de la astronomía. Lejos de reemplazar a los astrónomos, la IA está forjando una nueva y poderosa simbiosis. Al delegar las tareas computacionalmente intensivas y repetitivas a las máquinas, la IA libera a los investigadores humanos para que se centren en las actividades que requieren creatividad, intuición física y pensamiento crítico. La colaboración entre científicos profesionales, el público a través de la ciencia ciudadana y los algoritmos inteligentes, como se ejemplifica en el ciclo de Galaxy Zoo, es el modelo de este nuevo paradigma colaborativo. Mirando hacia el futuro, con la inminente llegada de los datos de observatorios como el Vera C. Rubin, el Telescopio Espacial Nancy Grace Roman y el Square Kilometre Array, la dependencia de la IA no hará más que aumentar. La astronomía del siglo XXI se definirá por esta asociación entre la inteligencia humana y la artificial. Juntas, explorarán el cosmos con una profundidad y una amplitud nunca antes imaginadas, desvelando los secretos de la formación de las galaxias, la naturaleza de los mundos lejanos y la estructura fundamental de nuestro universo.

La astronomía del siglo XXI ha entrado en una era donde los telescopios ya no solo miran más lejos, sino que producen océanos de datos imposibles de recorrer sin ayuda. Del Hubble al James Webb, y pronto con el Rubin, el Roman y el SKA, la magnitud del desafío ha superado definitivamente la escala humana. Pero lejos de marginar al científico, la inteligencia artificial abre un paradigma de colaboración: la máquina filtra y clasifica, el astrónomo interpreta y crea, y la ciudadanía aporta ojos y diversidad. Esta alianza híbrida promete una exploración del cosmos más profunda, rápida y democrática que nunca.