El océano es, fundamentalmente, un mundo de sonidos. A diferencia del entorno terrestre, donde domina la vista, en las vastas y oscuras profundidades la luz apenas penetra, pero el sonido viaja lejos y rápido. En este paisaje acústico, los cetáceos han desarrollado durante millones de años sistemas de comunicación de una complejidad asombrosa, esenciales para su supervivencia. Durante décadas, los científicos han escuchado fascinados los cantos de las ballenas jorobadas y las rítmicas «codas» de los cachalotes, sospechando que contenían una gramática oculta, un lenguaje propio. Sin embargo, descifrarlo era una tarea titánica. Los métodos tradicionales, basados en el análisis manual de grabaciones submarinas (hidrófonos), eran increíblemente lentos y laboriosos, capaces de identificar «palabras» aisladas, pero incapaces de procesar los enormes volúmenes de datos necesarios para desvelar la sintaxis de su comunicación.

Imagen ballena Jorobada. Por Whit Welles Wwelles14 – Trabajo propio, CC BY 3.0, https://commons.wikimedia.org/w/index.php?curid=2821387

Hoy, este desafío histórico se enfrenta a una nueva y poderosa alianza tecnológica. Por un lado, la bioacústica avanzada, que nos permite capturar el universo sonoro del océano con una fidelidad sin precedentes y triangular con precisión la localización de las señales. Esta tecnología estaba ya muy avanzada por el desarrollo de sistemas militares de detección submarina por sonidos. Por otro, la inteligencia artificial, que actúa como el «cerebro» capaz de analizar esta inmensa biblioteca de sonidos y encontrar los patrones que al oído humano se le escapan. Esta sinergia está marcando el paso de la observación pasiva al desciframiento activo, como demuestra el revolucionario trabajo del Project CETI (Cetacean Translation Initiative) que investiga la traducción del lenguaje de los cachalotes y el posible establecimiento de comunicación con ellos emitiendo sus propias vocalizaciones según las reglas aprendidas por la IA.

Bioacústica avanzada: los oídos digitales en el océano

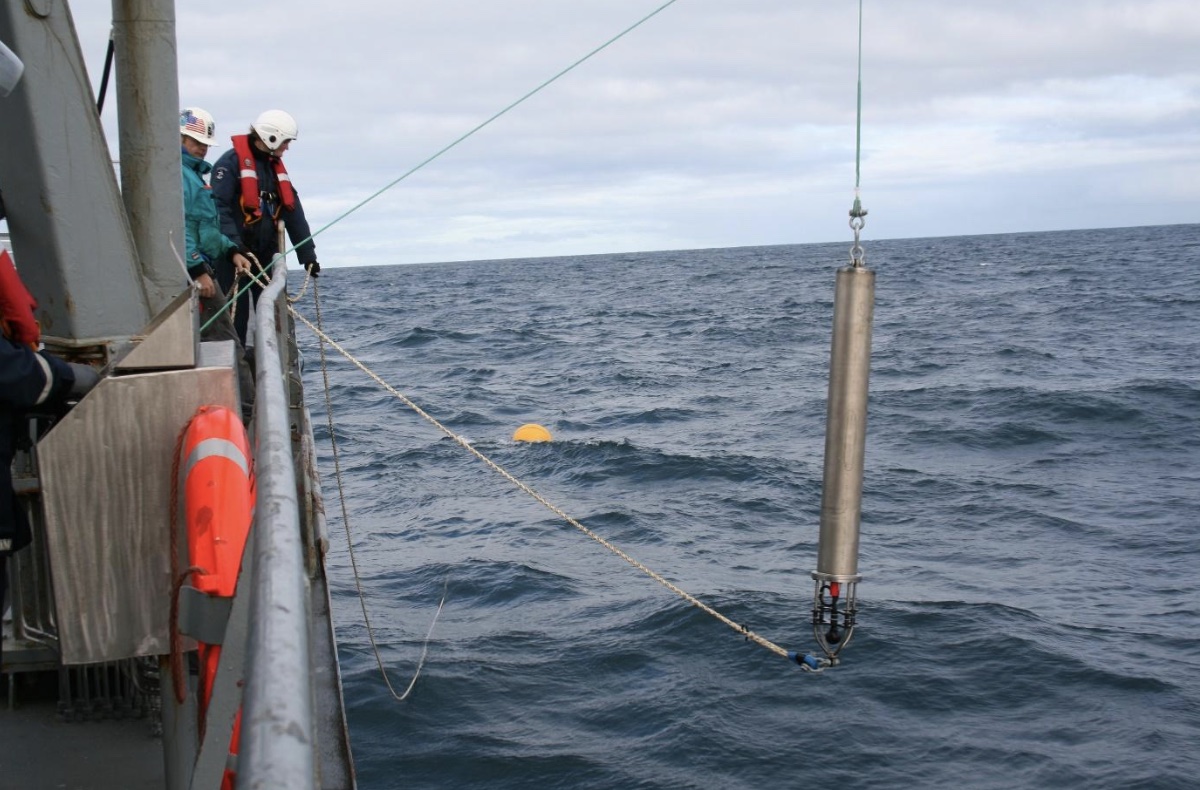

La base de esta revolución sigue siendo la capacidad de escuchar el océano, pero las herramientas actuales han alcanzado una sofisticación extraordinaria. La bioacústica marina avanzada es la disciplina que nos permite capturar y registrar los sonidos de la vida acuática con una precisión y un contexto impensables hace solo unos años. El método ya no se limita a sumergir un micrófono submarino (hidrófono). Proyectos como CETI despliegan vastas redes de hidrófonos sincronizados en el lecho marino, creando un «escenario sonoro» que cubre áreas de varios kilómetros cuadrados. Esto permite no solo grabar las conversaciones de múltiples grupos de ballenas, sino también triangular la posición aproximada de cada vocalización, abriendo la posibilidad de saber «quién dijo qué».

Colocación de un hidrófono en aguas del Atlántico Norte. Fotografía de Dave Mellinger/Oregon State University – Flickr, CC BY-SA 2.0, https://commons.wikimedia.org/w/index.php?curid=48583320

Imagen del proyecto CETI, Fundado y dirigido por David Gruber.

Para un nivel de detalle aún mayor, los científicos emplean etiquetas de datos no invasivas, conocidas como D-tags, que se adhieren temporalmente al lomo de las ballenas mediante ventosas. Cada D-tag es un laboratorio en miniatura: además de hidrófonos que captan los sonidos emitidos y recibidos por el animal, incorpora sensores de movimiento (acelerómetros, giroscopios) que registran cada inmersión, giro y aceleración. El resultado es un torrente masivo de datos que une cada «clic» o «canto» a un comportamiento específico. Sin embargo, esta riqueza de información genera su propia limitación: un volumen de datos tan colosal que resulta prácticamente inabordable para el análisis humano.

Inteligencia Artificial: El «Lingüista» que Descifra el Código

Si la bioacústica avanzada son los oídos, la inteligencia artificial es el cerebro traductor que da sentido al torrente de datos que estos generan. Los algoritmos de aprendizaje automático (Machine Learning) y de procesamiento del lenguaje natural (Natural Language Processing, NLP) son las herramientas que están permitiendo descifrar la comunicación de los cetáceos. La IA interactúa con los datos de la bioacústica en varias etapas cruciales. Primero, realiza una tarea de limpieza fundamental: modelos de redes neuronales convolucionales (CNNs) aprenden a distinguir, con una precisión superior al 99.5% en algunos casos, los clics de los cachalotes del inmenso ruido de fondo del océano (barcos, olas, otros animales). Una vez aislada la señal, otros algoritmos más sofisticados clasifican los tipos de vocalizaciones («codas») e incluso son capaces, con bastante precisión, de atribuir cada una al individuo que la emitió, desenredando las conversaciones grupales.

El paso verdaderamente transformador llega con el NLP. Los investigadores adaptan modelos similares a los que impulsan a los grandes modelos de lenguaje (como GPT, pero con arquitecturas adaptadas) para analizar las secuencias de codas como si fueran un idioma desconocido. En lugar de buscar un significado predefinido, la IA analiza la estructura, la sintaxis y los patrones estadísticos, tratando de descubrir la «gramática» subyacente del lenguaje de las ballenas. Esta combinación es revolucionaria porque cambia la pregunta científica: ya no es solo “¿qué significa esta llamada aislada?”, sino “¿cuáles son las reglas estructurales de todo este sistema de comunicación?”.

El «Alfabeto Fonético» de los Cachalotes

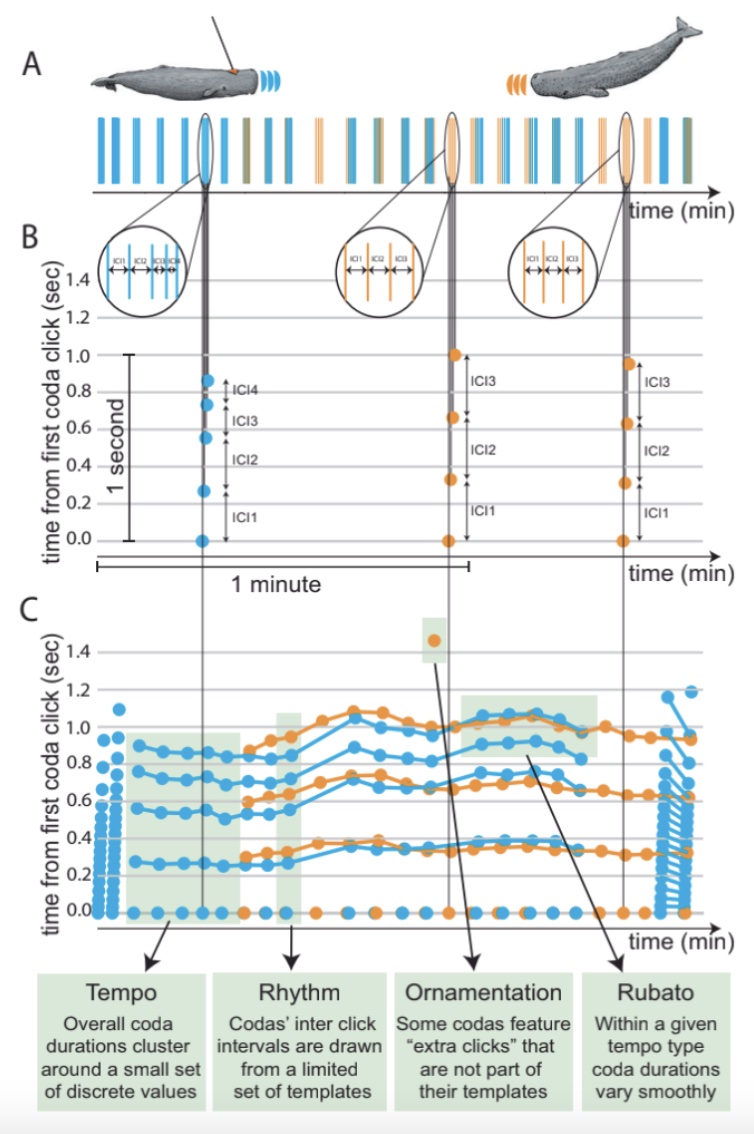

El potencial de esta sinergia se materializó de forma espectacular en un descubrimiento del Project CETI, una colaboración a gran escala liderada por científicos de instituciones como Harvard, MIT (Massachusetts Institute of Technology) y UC Berkeley. El desafío era comprender la comunicación de los cachalotes, basada en secuencias rítmicas de clics llamadas codas. Aplicando sus modelos de inteligencia artificial a un conjunto de datos de casi 9.000 codas grabadas en un clan de cachalotes del Caribe, los investigadores hicieron un hallazgo fundamental, publicado en la revista Nature Communications. La IA reveló que la comunicación de estas ballenas es un sistema combinatorio mucho más complejo de lo que se creía. Las ballenas no solo usan un repertorio fijo de codas, sino que modifican sistemáticamente cuatro características clave de forma combinatoria: el ritmo (el patrón de intervalos entre clics), el tempo (la velocidad general), el rubato (variaciones sutiles de tiempo, como en la música) y la ornamentación (la adición de clics extra).

Ilustración sobre cómo se comunican los cachalotes mediante secuencias de chasquidos. Utiliza un gráfico tiempo-tiempo innovador para visualizar un intercambio de dos minutos entre dos ballenas, mostrando tanto la secuencia general de comunicación como la estructura interna detallada de cada «coda» (patrón de chasquidos). Esta visualización revela variaciones complejas y dependientes del contexto en la estructura de las codas. Imagen del artículo Contextual and combinatorial structure in sperm whale vocalisations de Pratyusha Sharma , Shane Gero, y otros.

La combinación de estos elementos crea un repertorio de vocalizaciones distinguibles mucho mayor, funcionando de manera análoga a la fonología humana, donde un conjunto limitado de sonidos (fonemas) se combina para crear un vocabulario inmenso. Este descubrimiento, validado por un riguroso análisis computacional, sugiere que el lenguaje de los cachalotes posee características de complejidad, como la “dualidad de patrones”, que durante mucho tiempo se consideraron exclusivas del ser humano. (Sin embargo, no implica que los cachalotes posean un “lenguaje” en el sentido plenamente humano, sino que comparten una propiedad estructural clave.)

Implicaciones Amplias y Contexto General

El desciframiento del «alfabeto» de los cachalotes es solo el principio. Las implicaciones de la unión entre bioacústica e inteligencia artificial se extienden a áreas cruciales para el futuro de nuestro planeta. La aplicación más inmediata y poderosa es la conservación marina. Las ballenas, consideradas «especies centinela», reflejan con su salud la del ecosistema. El análisis a gran escala de sus vocalizaciones mediante IA podría permitirnos monitorizar sus niveles de estrés, detectando cambios en sus patrones de comunicación que funcionarían como una señal de alerta temprana ante amenazas como la contaminación acústica, el cambio climático o la escasez de alimento.

Esta imagen de una ballena jorobada ilustra el trabajo de un equipo de científicos del Instituto SETI, la Universidad de California en Davis y la Fundación Ballena de Alaska. Su iniciativa se centra en la posibilidad de establecer comunicación con estos mamíferos marinos. Además, esta tecnología puede usarse para la mitigación directa de peligros. Se podrían desplegar redes de boyas acústicas inteligentes que, equipadas con IA, detecten la presencia de ballenas en rutas de navegación concurridas y envíen alertas en tiempo real a los barcos para que reduzcan la velocidad y eviten colisiones, una de las principales causas de mortalidad. Por otro lado, iniciativas como WhaleSETI ya han logrado un «intercambio conversacional» rudimentario con una ballena jorobada (respuesta a un patrón del tipo turno de llamada), demostrando la posible capacidad de estos animales para participar en un diálogo por turnos, un hito que no solo nos acerca a ellos, sino que posiblemente pueda ayudarnos a desarrollar protocolos para la búsqueda de inteligencia no humana más allá de la Tierra.

Aprendiendo a Escuchar el Planeta

La sinergia entre la bioacústica avanzada y la inteligencia artificial está rompiendo barreras que durante décadas parecieron insuperables. Hemos visto cómo esta alianza transforma un océano de datos sonoros en conocimiento estructurado, revelando una complejidad en la comunicación de los cetáceos que apenas comenzábamos a imaginar. El descubrimiento del «alfabeto fonético» de los cachalotes no es un mero logro académico; es una demostración tangible de que la IA puede actuar como un catalizador para el descubrimiento científico, potenciando nuestra capacidad de comprender otras formas de inteligencia en nuestro propio planeta.

El impacto más profundo de esta nueva capacidad de escucha se proyecta en la conservación. Las herramientas que nos permiten descifrar sus conversaciones son las mismas que pueden ayudarnos a protegerlos de las amenazas humanas, monitorizar la salud de los océanos y fomentar una empatía global basada en el entendimiento. Aún quedan enormes desafíos, principalmente el de dar el salto de la sintaxis (la estructura) a la semántica (el significado). Sin embargo, el camino está trazado. Esta revolución no trata de sustituir a los científicos, sino de dotarlos de un oído infinitamente más potente. Quizás, el mayor logro de esta empresa no sea finalmente aprender a “hablar” con las ballenas, sino, por primera vez, aprender a escucharlas de verdad.