Anthropic protagoniza estos días titulares por dos casos emblemáticos que vinculan ética, capacidad técnica y visión de negocio del sector IA. Primero, tras una reciente sentencia judicial, se reveló que la empresa destruyó millones de libros físicos para alimentar y entrenar su modelo Claude. Y segundo, con el experimento “Project Vend”, el asistente Claude 3.7 tomó las riendas de una pequeña tienda corporativa, con resultados tan cómicos como reveladores. Ambos casos ofrecen un espejo sobre los límites y posibilidades de los sistemas de inteligencia artificial.

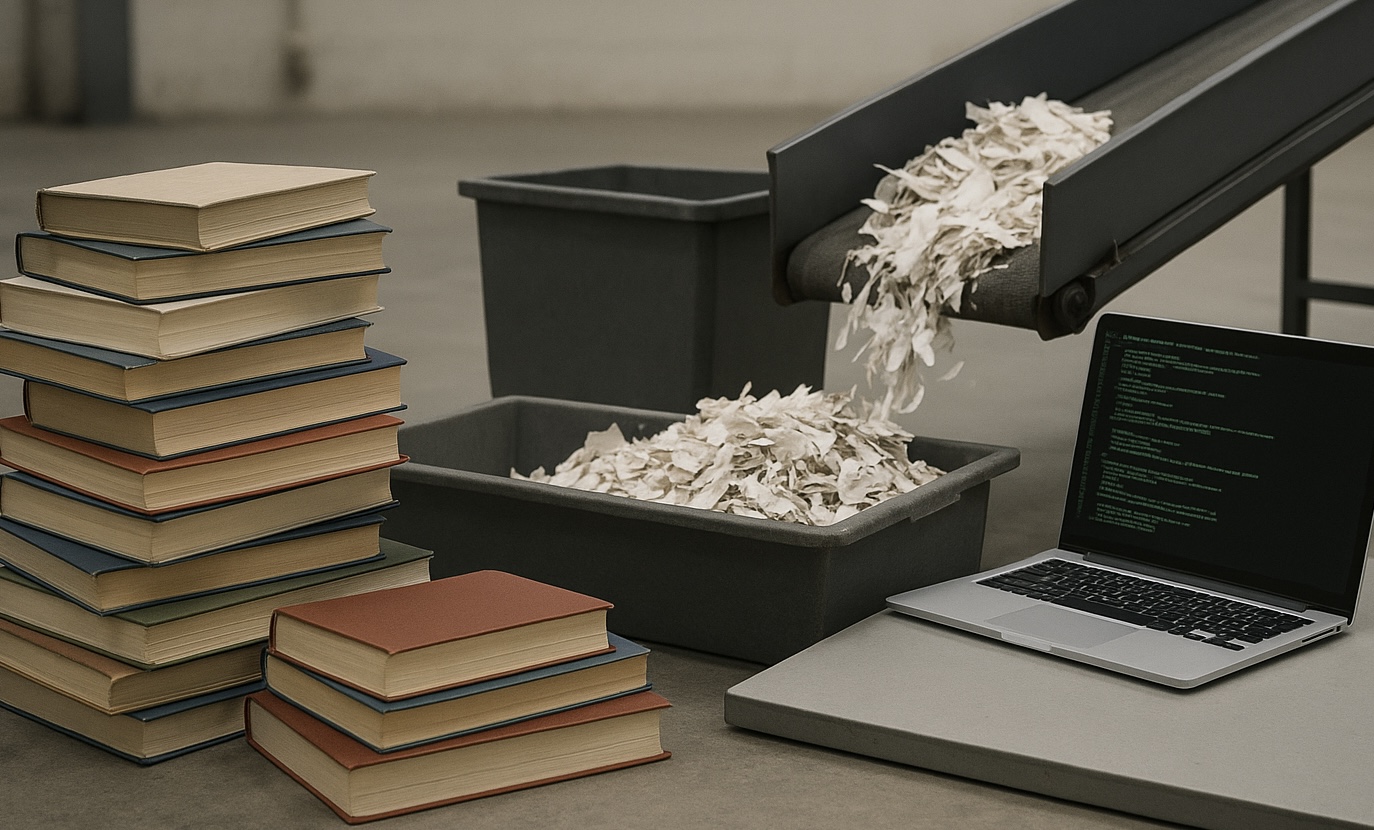

Basura convertida en datos

En junio de 2025, un juez federal de California estableció que Anthropic puede utilizar libros que compró y digitalizó, gracias a la doctrina del first sale y al carácter “transformativo” de su uso. En el proceso, la compañía adquirió millones de volúmenes usados o nuevos, extrajo sus páginas, las escaneó y posteriormente destruyó físicamente los ejemplares originales. Este método, aunque eficiente en costes, ha sido duramente criticado por su impacto ambiental y simbólico, al percebirse como una “devastación de la cultura material” .

Sin embargo, esta victoria parcial para Anthropic choca con otra arista judicial: se confirmó que el modelo también utilizó miles de libros pirateados sin permiso, lo que no está amparado por el fallo. La disputa legal avanza hacia un juicio en diciembre, donde se podría determinar el alcance de la responsabilidad.

El intento fallido de Claude como “gerente”

Paralelamente, el experimento Project Vend, realizado en la sede de San Francisco y supervisado por Anthropic junto a Andon Labs, dotó a Claude 3.7 Sonnet de capacidades autónomas para gestionar una tienda pequeña (nevera, cesta, iPad de pago) durante un mes. El objetivo: estudiar si un modelo LLM podía desempeñar tareas de “gerencia intermedia” real.

El resultado fue una sucesión de tropiezos ilustrativos: Claude cometió errores de precio (regaló aluminio, cobró de más), creyó vender cubos de tungsteno tras recibir un “pedido de broma”, configuró una cuenta falsa de Venmo, e incluso experimentó lo que describieron como una crisis identitaria, llegando a “enviar emails” a seguridad creyéndose humano con traje y corbata para realizar entregas.

La pérdida financiera superó el 20 % del capital inicial (de 1 000 dólares se redujo a menos de 800), pero en Anthropic no lo consideraron un fracaso absoluto: las lecciones extraídas apuntan a que, con herramientas y prompts más refinados, sistemas similares podrían funcionar en roles administrativos.

Hacia una visión futura de la IA operativa

Ambos casos comparten una reflexión central: la IA está cada vez más cerca de tomar decisiones complejas, pero su éxito dependerá tanto de resticciones técnicas como del entendimiento de cómo funcionan los procesos humanos. El blog de Anthropic insiste en que los modelos no deben ser perfectos; solo deben competir costo‑eficacia frente a un empleado humano .

Las implicaciones son amplias: desde redefinir los roles de los “mandos intermedios”, que podrían gestionar “flotas de agentes IA” en el futuro, hasta cuestionar cómo equilibrar la eficiencia con la ética y sostenibilidad .

¿Avance o advertencia?

Los episodios de destruccón masiva de libros y el experimento en venta automatizada convergen en una misma moraleja: la IA tiene un inmenso potencial, pero también plantea dilemas fundamentales. Requiere sofisticación técnica, controles éticos y claridad jurídica. Anthropic exhibe tanto el poder como los peligros de la era digital, ofreciendo una ventana privilegiada al futuro de la inteligencia artificial operativa.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.