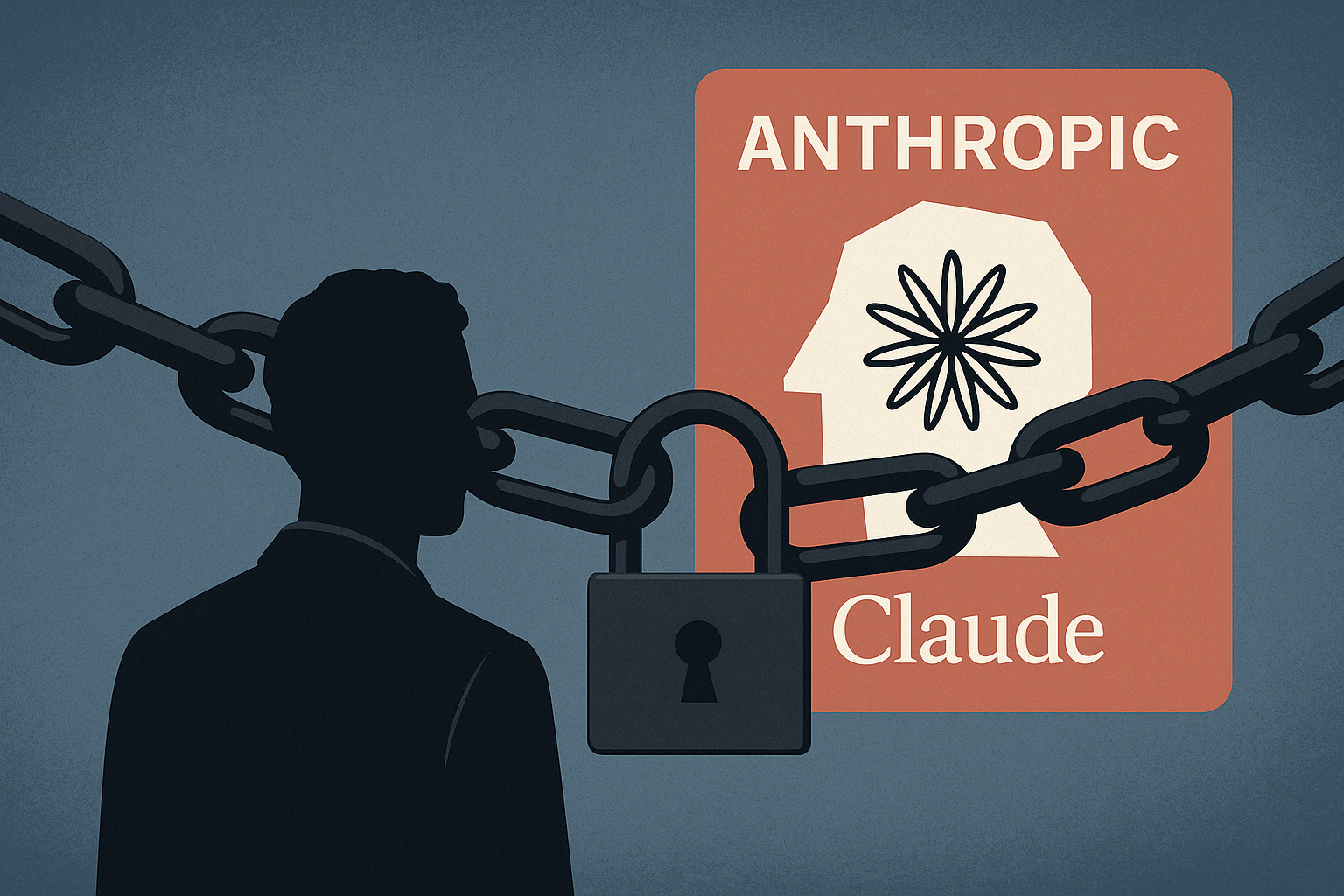

Cuando una compañía de inteligencia artificial cierra el acceso a otra, el gesto va más allá de lo técnico. Esta semana, según ha podido saber Wired, Anthropic revocó el uso de su API Claude a OpenAI tras descubrir que el equipo de esta última estaba utilizando sus herramientas de código para afinar GPT-5. La decisión marca un nuevo capítulo en una competencia que ya es estratégica, comercial y filosófica.

Claude como espejo de GPT-5

OpenAI no usaba la versión pública de Claude, sino accesos específicos que permiten integrar el modelo en flujos internos. A través de esta vía, sometió a Claude a pruebas en programación, escritura y manejo de temas delicados como autolesiones o contenido abusivo. Todo, según Anthropic, con el objetivo de calibrar y comparar su propio modelo en desarrollo: GPT-5. Un benchmarking que, desde el punto de vista contractual, habría cruzado límites.

Los términos que saltaron por los aires

Anthropic alega que sus condiciones de servicio prohíben usar Claude para crear servicios competidores, entrenar otros modelos o replicar su tecnología. Aunque comparar sistemas es práctica común en el sector, la empresa sostiene que hacerlo desde una posición interna, con acceso privilegiado, rompe el acuerdo. El resultado: cancelación inmediata del acceso.

OpenAI responde: competir es avanzar

Desde OpenAI, la respuesta ha sido medida pero crítica. Alegan que comparar modelos es vital para evaluar seguridad, detectar fallos y mejorar capacidades. Aunque reconocen el derecho de Anthropic a limitar el uso, subrayan que su propia API sigue abierta a evaluaciones externas. En un gesto conciliador, aseguran que podrán seguir haciendo pruebas limitadas con Claude para garantías de seguridad, aunque no queda claro bajo qué condiciones.

Claude Code y otras tensiones previas

El conflicto no es aislado. Hace semanas, Anthropic también vetó a Windsurf, una startup centrada en código, tras rumores de una posible adquisición por parte de OpenAI. Jared Kaplan, director científico de Anthropic, fue directo: “Sería raro vender Claude a OpenAI”. Además, el mismo día del corte, la empresa anunció límites semanales para el uso de Claude Code, alegando alta demanda y cuatro interrupciones recientes del servicio.

Las APIs ya no son neutrales

El caso refleja un dilema creciente. Las APIs permiten crecer, pero también exponen. Empresas como Meta o Salesforce han restringido accesos en el pasado para evitar usos que comprometan su ventaja competitiva. En el caso de la IA generativa, donde el entrenamiento y evaluación dependen de grandes volúmenes de interacción, la protección de modelos se convierte en estrategia.

No solo modelos, también maneras de pensar

La historia también tiene un trasfondo. Anthropic nació de una escisión de OpenAI. Sus fundadores impulsaron una visión más enfocada en la seguridad y la transparencia, frente al ritmo agresivo de su predecesora. Claude y ChatGPT no solo compiten por usuarios, sino por imponer una forma de entender la inteligencia artificial.

Quién impone las reglas del juego

Cerrar una API no es solo un gesto técnico: es una forma de marcar límites en un entorno donde las normas aún se escriben sobre la marcha. Anthropic defiende sus límites contractuales; OpenAI insiste en la necesidad de comparar para avanzar. Entre ambos, queda la pregunta: ¿qué significa competir limpiamente en un sector donde el código es invisible pero las decisiones son políticas?

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.