Con su nueva app para macOS, OpenAI deja de vender “un copiloto” y propone otra cosa: gestionar varios agentes en paralelo sobre el mismo repositorio, con worktrees, skills y automatizaciones —y, de paso, duplica límites en planes de pago.

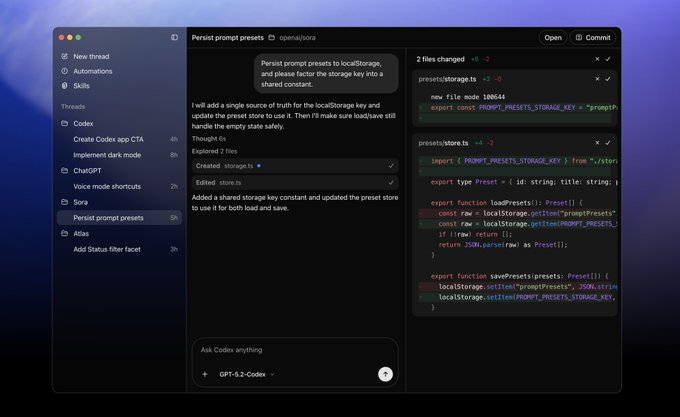

OpenAI acaba de poner sobre la mesa un cambio de interfaz que es, en realidad, un cambio de modelo mental. Ya no se trata de escribir una línea y que la IA la complete, ni de “pair programming” con un único asistente dentro del IDE. La nueva aplicación de escritorio de Codex para macOS se presenta como un “command center for agents”: un lugar desde el que lanzar tareas largas, dividir trabajo, supervisar diffs limpios y coordinar múltiples hilos de ejecución como si fueran miembros de un equipo.

El lanzamiento llega con dos decisiones comerciales que apuntan a adopción masiva: por tiempo limitado, Codex se incluye también para usuarios ChatGPT Free y el plan Go, y además OpenAI duplica los rate limits en Plus, Pro, Business, Enterprise y Edu (según la nota oficial, el incremento aplica “en todas partes donde uses Codex”: app, CLI, IDE y cloud).

En paralelo, el movimiento tiene una lectura competitiva directa: el terreno de las herramientas de programación es hoy el segmento más peleado de la IA aplicada al trabajo, con Anthropic ganando tracción en empresas y productos como Microsoft manteniendo ventaja por integración (GitHub Copilot) mientras los equipos buscan productividad inmediata sin rehacer procesos.

De “asistente” a “equipo”: la interfaz como estrategia

La propia descripción oficial reconoce que el cuello de botella ya no es solo lo que el modelo “sabe” hacer, sino cómo una persona puede dirigirlo a escala. Las herramientas clásicas —IDE y terminal— están pensadas para un humano haciendo cambios y, como mucho, una IA sugiriendo. En cambio, cuando la IA ya puede ejecutar tareas de principio a fin, el problema pasa a ser coordinación: asignar trabajos, comparar resultados, evitar conflictos, revisar con rapidez y mantener trazabilidad.

Ahí entra la app: tareas separadas en threads por proyecto, con una zona de revisión donde inspeccionar cambios, comentar el diff y, si hace falta, abrir en el editor para retoques manuales. Es decir: la aplicación se coloca entre el repositorio y el desarrollador como una capa de orquestación, no como un simple chat.

El mensaje es coherente con lo que explicó Sam Altman en entrevistas sobre el producto: que internamente lo consideran el “producto más querido” y que él mismo ha hecho proyectos sin abrir un IDE en el proceso, desplazando el trabajo hacia delegación + revisión.

Subagentes en el mismo directorio, sin pisarse: por qué importan los worktrees

La pieza técnica que hace creíble el “multiagente” en un repositorio real es el soporte integrado de worktrees. En términos prácticos: cada agente trabaja sobre una copia aislada del mismo repo, de manera que puedes mandar a uno a refactorizar, a otro a escribir tests, y a un tercero a preparar documentación sin crear un conflicto continuo de git. Luego comparas diffs y decides qué entra.

Esto no es un capricho: es la diferencia entre “ejecutar varias cosas” y “poder hacerlo todos los días sin incendiar el repositorio”. Y además encaja con el caso de uso que mencionas (subagentes sobre el mismo directorio): la app pide elegir una carpeta o repositorio local como “workspace” y, desde ahí, las tareas se lanzan sobre ese contexto con límites y permisos.

Skills: pasar de escribir código a ejecutar trabajo

El otro salto conceptual es Skills. OpenAI las define como paquetes de instrucciones + recursos + scripts para que Codex pueda conectarse con herramientas y ejecutar flujos de trabajo con las convenciones del equipo. No es “prompt engineering” suelto: es convertir procedimientos repetibles en capacidades invocables.

En la práctica, esto apunta a dos cosas:

-

Estandarización interna: tu equipo define “cómo se hacen aquí” las cosas (naming, linters, PR checklist, despliegues, estructura de carpetas) y lo encapsula en skills.

-

Extensión a tareas adyacentes: diseño (por ejemplo, traer contexto de Figma), gestión (Linear), despliegue (Cloudflare/Vercel) o generación de assets, todo desde el mismo “centro de mando”, sin que el usuario tenga que coser integraciones cada vez.

La demo que OpenAI usa para vender la idea es significativa: pedir un juego de carreras desde un prompt y dejar que el sistema trabaje con skills para imagen y desarrollo web, consumiendo millones de tokens y validando como “QA” al jugarlo. Es más marketing que benchmark científico, pero ilustra la tesis: un agente no solo escribe archivos; usa herramientas y cierra el bucle de verificación.

Automations: trabajo “en cola” con revisión humana

La tercera pata es Automations: programar tareas repetitivas (triage de issues, resúmenes de fallos de CI, briefs de release, búsquedas de regresiones) y recibir el resultado en una review queue. Internamente, el equipo de Codex afirma usarlo para ese tipo de tareas mecánicas pero constantes.

El matiz importante es de diseño: no es “ejecución ciega”, sino ejecución con punto de control humano. La app está pensada para que delegues, pero también para que reviertas, edites o rechaces con fricción baja.

Seguridad: sandbox por defecto, permisos granulares

Si vas a dar autonomía a agentes en el entorno local, la seguridad deja de ser un epílogo: es la arquitectura. OpenAI insiste en sandboxing “nativo” y configurable, con restricciones por defecto (editar solo dentro de la carpeta/branch de trabajo, uso de búsqueda web cacheada, y solicitud de permiso para acciones elevadas como acceso de red). Además, remarca que parte del sandbox es open source.

En lectura empresarial, esto responde a un miedo clásico: “¿voy a dejar que un agente toque mi repo y ejecute comandos?”. El enfoque de permisos persistentes —autorizar una acción concreta “de ahora en adelante” sin abrir la puerta a todo— busca equilibrio entre control y productividad.

Por qué ahora: presión competitiva y gasto enterprise

La app no aparece en el vacío. Un análisis reciente de Andreessen Horowitz sitúa a OpenAI como líder en adopción enterprise (78% de CIOs encuestados usando sus modelos en producción), pero con Anthropic creciendo rápido y con un patrón claro: las empresas ya trabajan con múltiples familias de modelos, el “single vendor” pierde fuerza y la batalla se decide por producto + integración + confianza.

En ese contexto, una app de escritorio con multiagente, worktrees, skills y automatizaciones es una jugada defensiva y ofensiva:

-

Defensiva, porque evita que el “lugar donde codificas con IA” quede monopolizado por otros (desde Claude Code hasta herramientas integradas en IDEs).

-

Ofensiva, porque desplaza la conversación: no compite solo en “calidad de autocompletado”, sino en “capacidad de ejecutar trabajo largo en paralelo”, que es donde se decide el ROI para equipos serios.

Reuters lo formula con crudeza: OpenAI busca recuperar terreno en coding, un caso de uso estrella para vender IA a empresas, en un mercado donde sus rivales han ganado narrativa y cuota.

La promoción de límites duplicados no es un regalo: es una palanca de hábito

La duplicación temporal de rate limits en planes de pago y la apertura a Free/Go no son solo marketing. En productos de agentes, el coste real para el usuario no es “probar una vez”, sino construir hábito: pasar de una tarea a la vez a muchas tareas concurrentes, revisar rápido, iterar, y convertir el sistema en parte del flujo diario.

Si el usuario se queda sin límites cuando empieza a trabajar “en paralelo”, se corta el aprendizaje. Si, en cambio, tienes margen para lanzar varias tareas y comparar resultados, es más probable que cruces el umbral de “esto ya no es un juguete”. La nota oficial lo deja claro: la subida de límites aplica a todas las superficies (app, CLI, IDE, cloud) precisamente para evitar que el usuario choque con paredes según el canal.

macOS hoy, Windows mañana: el verdadero objetivo

La app se estrena en Mac y OpenAI confirma que Windows llegará después. Ese detalle importa por una razón obvia: el mercado de desarrollo profesional y corporativo sigue muy cargado hacia Windows en muchos entornos, y una herramienta de “centro de mando” solo se vuelve estándar cuando está donde trabaja la masa crítica.

Pero el objetivo de fondo va más allá de sistema operativo: convertir la programación en la interfaz universal para pedirle trabajo al ordenador, sea código, análisis, documentación o tareas operativas. La app de escritorio es el primer gesto serio de “agentes como plantilla”, no como chat.