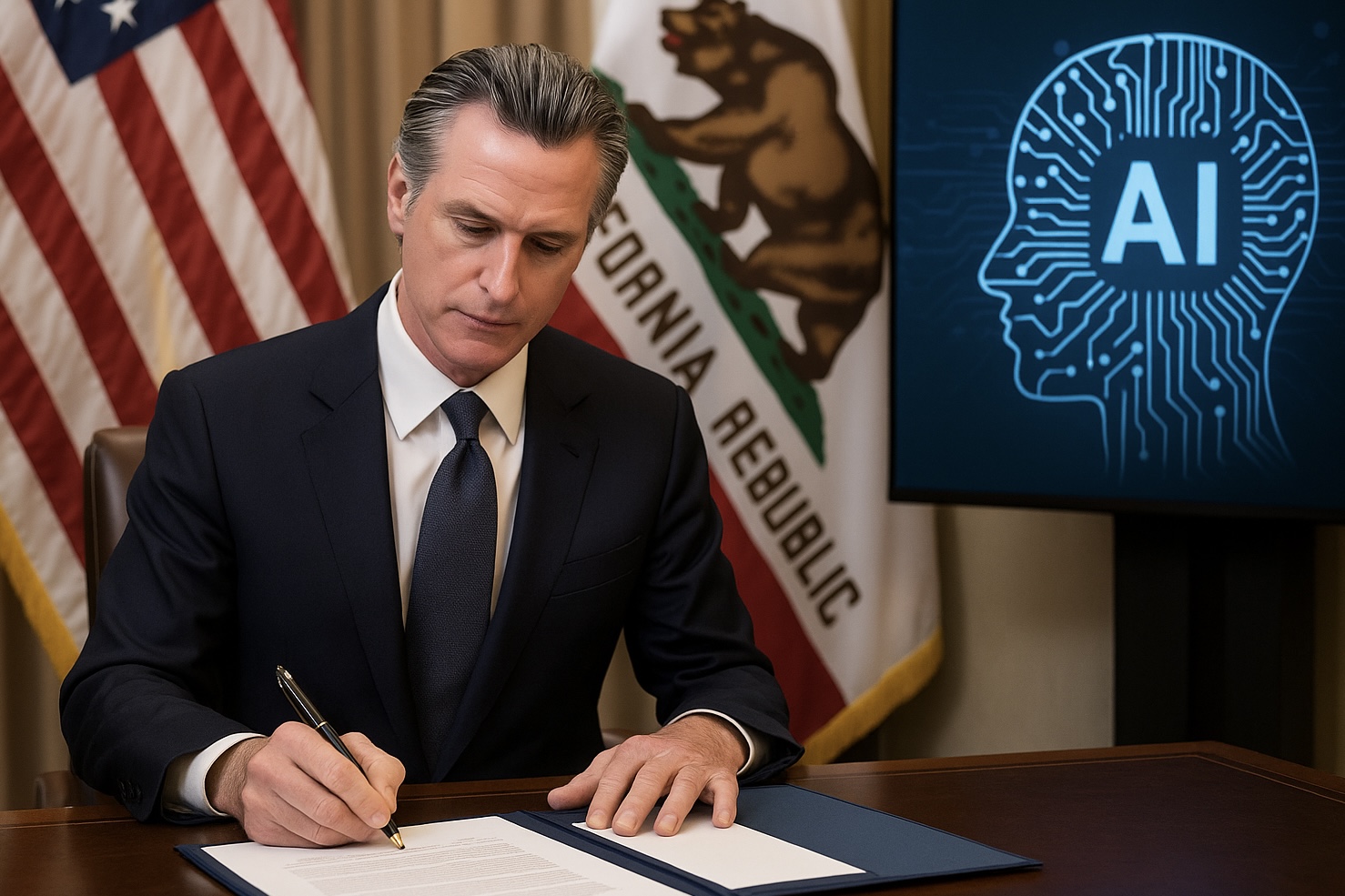

El 29 de septiembre de 2025, el gobernador de California Gavin Newsom firmó la ley SB 53, titulada Transparency in Frontier Artificial Intelligence Act, convirtiéndose en la primera jurisdicción estadounidense en imponer obligaciones de transparencia sobre el diseño interno de modelos de inteligencia artificial “fronterizos”. La norma obliga a grandes empresas de IA (como OpenAI, Anthropic, Meta, Google DeepMind) a publicar protocolos de seguridad, reportar incidentes críticos y proveer mecanismos de denuncia interna, bajo riesgo de multas.

SB 53 fue aprobada hace dos semanas por la legislatura estatal, luego de que Newsom el año pasado vetara una versión más ambiciosa (SB 1047) que imponía auditorías más estrictas y sanciones mayores. La nueva versión incorpora recomendaciones de un grupo de trabajo convocado por el gobernador, con expertos en IA como Fei-Fei Li, que buscaron equilibrar la seguridad pública con la innovación.

Uno de los aspectos más innovadores de SB 53 es la obligación de reportar “incidentes peligrosos” —por ejemplo, comportamientos engañosos detectados durante pruebas del modelo— a la Oficina de Servicios de Emergencia del estado dentro de un plazo de 15 días. Se protege además a quienes denuncien internamente irregularidades, con cláusulas para salvaguardar su anonimato y prevenir represalias.

La norma aplica sólo a desarrolladores que superen ciertos umbrales de recursos (por ejemplo, ingresos mayores a 500 millones de dólares) o que operen modelos en la frontera tecnológica. Además, SB 53 crea “CalCompute”, una infraestructura pública de cómputo estatal destinada a facilitar el acceso de startups y académicos a recursos de IA avanzados.

La reacción en la industria ha sido mixta. Algunas compañías como Anthropic saludaron el paso como un marco pragmático hacia responsabilidad voluntaria. Pero grandes tecnológicas como Meta y OpenAI presionaron activamente en contra, argumentando que una regulación a nivel estatal puede generar un mosaico de normas difíciles de cumplir. Críticos advierten que permitir a cada estado legislar podría encarecer la innovación para empresas que operan en múltiples jurisdicciones.

Con esta ley, California aspira a posicionarse como líder en gobernanza de IA en ausencia de una normativa federal unificada. En palabras de Newsom: “esta legislación alcanza ese equilibrio: proteger nuestras comunidades mientras aseguramos que la industria continúe prosperando”.

Con todo, los retos persisten: la definición de “riesgo catastrófico” (daños equivalentes a 1 000 millones de dólares o más de 50 muertes), los detalles de verificación externa, la coordinación con normativa de la UE o congresos federales, y la vigilancia efectiva del cumplimiento en empresas transnacionales. Esta ley marca un hito simbólico: que la innovación debe caminar de la mano de responsabilidad y transparencia.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.