El camuflaje perfecto y la respuesta inteligente.

En el complejo tablero de la ciberseguridad actual, existe una amenaza que no necesita virus ni códigos maliciosos para vaciar las cuentas de una empresa: el Business Email Compromise (BEC). Este fraude, basado en la suplantación de identidad y la manipulación psicológica, ha evolucionado de simples correos con faltas de ortografía a sofisticadas campañas de ingeniería social. Según informes recientes de 2025, las pérdidas globales por BEC siguen creciendo, demostrando que el «firewall» humano sigue siendo vulnerable ante la urgencia y la autoridad simulada.

Las estimaciones disponibles sitúan las pérdidas globales asociadas al Business Email Compromise (BEC) en varios miles de millones de dólares anuales, con rangos que van desde decenas de miles de millones acumulados hasta más de 10–20 mil millones de dólares por año, aunque estas cifras varían notablemente según la fuente, el periodo analizado y la metodología empleada (por ejemplo, si se incluyen solo casos denunciados o también estimaciones indirectas).

Tradicionalmente, las defensas se han centrado en filtros que buscan enlaces sospechosos o archivos infectados. Sin embargo, el moderno “fraude del CEO” suele ser técnicamente “limpio”: correos que parecen legítimos, enviados desde cuentas comprometidas o desde dominios muy similares a los originales, y redactados con un alto grado de verosimilitud gracias a técnicas avanzadas de ingeniería social. En estos casos, los enfoques convencionales basados únicamente en la detección de malware o enlaces maliciosos resultan insuficientes, al no existir indicadores técnicos evidentes de engaño.

Publicación EL PAIS de septiembre de 2024. https://l1nq.com/7cglP

Para enfrentar este reto, se investigan y desarrollan enfoques tecnológicos complementarios. Por un lado, la estilometría computacional, apoyada en técnicas avanzadas de procesamiento del lenguaje natural (NLP), permite analizar patrones lingüísticos recurrentes y desviaciones respecto al estilo habitual de un remitente. Por otro, los sistemas de IA basados en múltiples agentes y análisis contextual buscan integrar señales adicionales —como el contexto de la transacción o anomalías operativas— para apoyar la detección de fraudes complejos. En conjunto, estas líneas de investigación apuntan a reforzar las capacidades defensivas de las organizaciones frente a ataques de ingeniería social cada vez más sofisticados.

La huella dactilar de las palabras. Estilometría y NLP

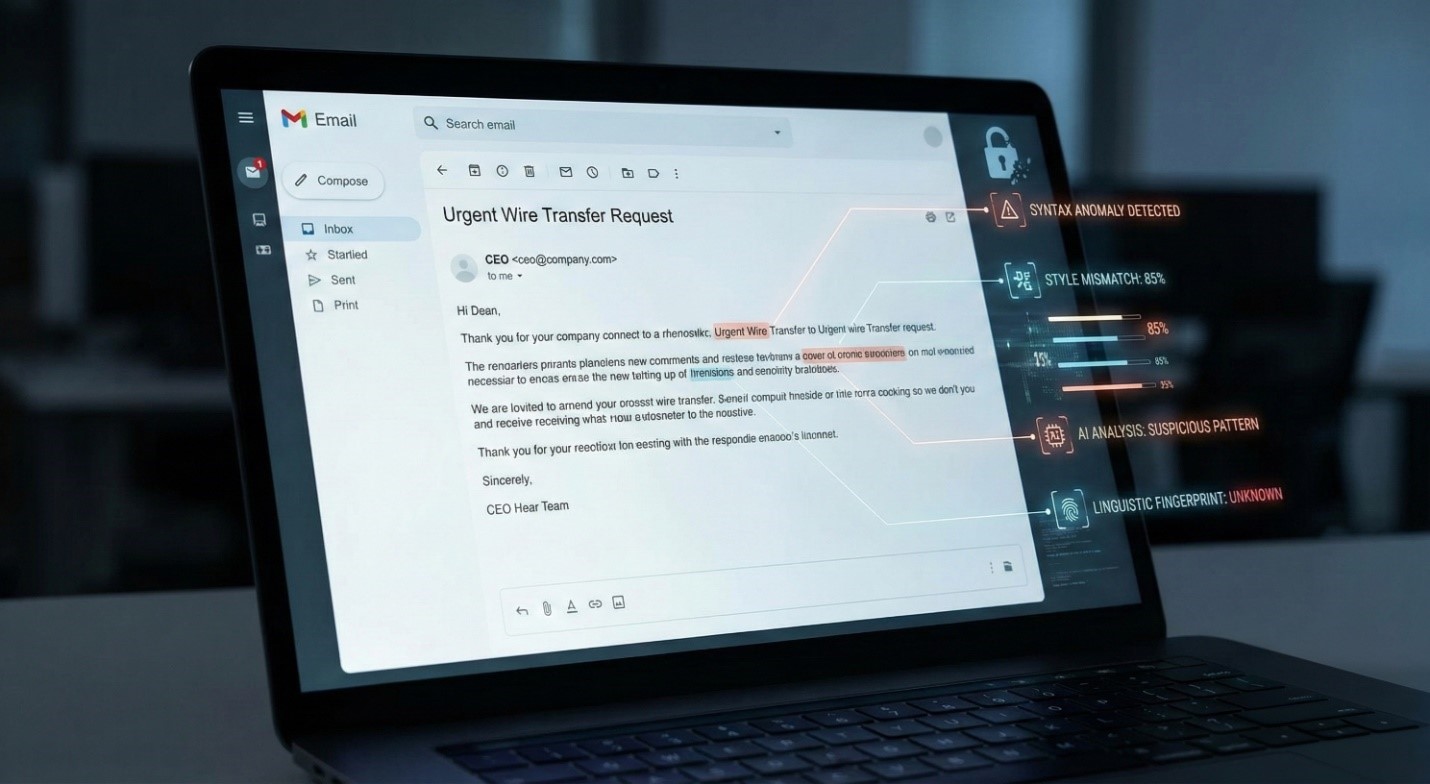

Antes de ver cómo la IA “razona”, conviene entender cómo puede “leer” más allá de lo evidente. La base de este enfoque es el análisis estilométrico apoyado en técnicas de Procesamiento de Lenguaje Natural (NLP).

Las personas tienden a mostrar patrones relativamente consistentes en su forma de escribir, como el uso de determinadas palabras de enlace, una longitud media de frase característica o preferencias en signos de puntuación. La estilometría es la disciplina que estudia y cuantifica estos rasgos lingüísticos. En el contexto del BEC, los sistemas de NLP pueden analizar el histórico de correos de un usuario legítimo (por ejemplo, un director financiero) para extraer patrones de estilo habituales.

A partir de ese histórico, el sistema construye un perfil estilístico aproximado del usuario: si suele emplear un tono formal, determinados saludos o estructuras de frase más largas o más breves. Cuando llega un correo nuevo, el texto puede compararse con ese perfil para identificar posibles desviaciones. En escenarios de suplantación, como un mensaje urgente solicitando una transferencia, este análisis puede revelar diferencias sutiles en la sintaxis o en el vocabulario respecto al patrón habitual del supuesto remitente. No obstante, esta tecnología tiene límites claros: los estilos de escritura humanos son variables y la IA generativa actual permite producir textos cada vez más coherentes, lo que reduce la fiabilidad de la estilometría como señal única y puede incrementar el riesgo de falsos positivos si se utiliza de forma aislada.

La Sinergia: Cuando la IA aprende a investigar

Aquí es donde entra la segunda pieza del rompecabezas, transformando una simple alerta en una investigación autónoma e inteligente.

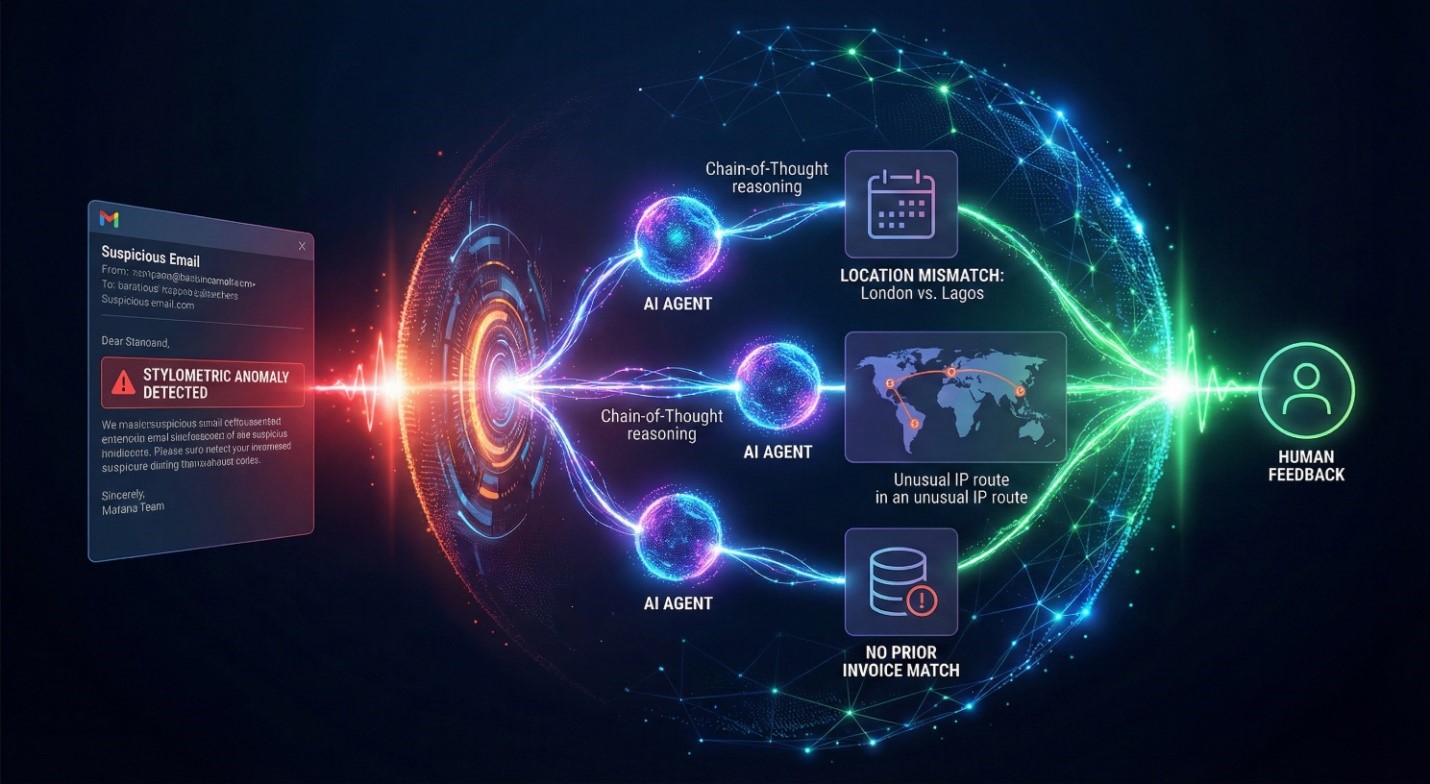

Sistemas Multi-Agente y Razonamiento (Chain-of-Thought) Si el NLP es el «lector», los Agentes de IA son los «detectives». Un agente de IA no es un modelo pasivo; es un sistema diseñado para ejecutar acciones y tomar decisiones siguiendo un proceso de razonamiento lógico. Cuando el módulo de estilometría detecta una anomalía sutil en un correo, despierta al Agente. Este tiene capacidad para usar «herramientas»: puede consultar el calendario del directivo, verificar el historial de facturas o analizar la geolocalización.

La combinación transformadora: Un sistema que evoluciona La verdadera revolución de este enfoque reside en su capacidad de auto-optimización. A diferencia del software de seguridad tradicional, que es estático y espera una actualización manual para reconocer nuevas amenazas, estos agentes aprenden de la experiencia. Utilizando arquitecturas de memoria y aprendizaje por refuerzo, el sistema evalúa sus propios éxitos y fracasos.

Si un agente detecta un ataque complejo o, por el contrario, comete un error (un falso positivo) y es corregido por un operador humano, el sistema reconfigura sus parámetros internos inmediatamente. Esto significa que la defensa evoluciona orgánicamente: el agente se vuelve más «astuto» con cada interacción, adaptando sus estrategias de búsqueda y verificación a la misma velocidad vertiginosa a la que los cibercriminales modifican sus técnicas de engaño. Ya no es solo un muro; es un sistema inmunitario digital que madura.

El incidente «Alpine Business»

Para ilustrar esta tecnología, analicemos un caso de estudio, de laboratorio, derivado de investigaciones recientes en la Escuela Politécnica Federal de Lausana (EPFL) sobre sistemas multi-agente. Una empleada de finanzas, «Sophie», recibe un correo de su supuesta CEO, «Clara», un viernes por la tarde. El asunto: «Adquisición Confidencial». El cuerpo del mensaje exige una transferencia inmediata de 150.000 CHF a una cuenta nueva para cerrar un trato secreto, advirtiendo que no se debe hablar con nadie por motivos regulatorios. Es un ataque BEC de libro.

Imagen de las intalacionesd e la EPFL en Lausanne, Suiza.

Detección Inicial (NLP): El análisis estilométrico nota que el correo usa un tono ligeramente más imperativo de lo habitual en Clara y una estructura de despedida atípica. Se genera una alerta de nivel medio.

1. Investigación del Agente: El sistema multi-agente se activa.

- Paso 1: El agente consulta el calendario corporativo de Clara. Resultado: No hay viajes ni reuniones de fusiones programadas; Clara está en la oficina.

- Paso 2: El agente verifica el IBAN de destino. Resultado: Es la primera vez que se ve esa cuenta y no coincide con la lista de proveedores aprobados.

- Paso 3: El agente analiza la semántica de «urgencia y secreto». Reconoce esto como un patrón de persuasión coercitiva común en fraudes.

2. Resultado: El sistema combina la anomalía lingüística con la inconsistencia factual. Bloquea el correo y envía una alerta de seguridad explicada: «Posible suplantación: Estilo inusual + Solicitud financiera anómala + Inconsistencia de ubicación».

Lección: Un filtro tradicional habría dejado pasar el correo porque no contenía malware. Un sistema solo de NLP podría haber dudado. La combinación salvó a la empresa de una pérdida millonaria.

Una necesidad en el ecosistema europeo

La tecnología descrita no pertenece a la ciencia ficción, sino que responde a desafíos reales del panorama actual de la ciberseguridad, especialmente en regiones como Europa, donde la ingeniería social se ha consolidado como una de las principales amenazas.

El informe de amenazas de ENISA 2024-2025 señala que el phishing y otras formas de ingeniería social continúan siendo uno de los vectores de entrada más frecuentes para los ciberataques en la Unión Europea. Las PYMES españolas y europeas figuran entre los colectivos más afectados, en parte porque participan en cadenas de suministro y operaciones transfronterizas, y a menudo disponen de recursos limitados en comparación con grandes organizaciones, lo que dificulta mantener capacidades de vigilancia y respuesta continuas.

Además, se observa una tendencia creciente al uso de herramientas basadas en IA tanto en actividades ofensivas como defensivas. Diversos informes documentan que los atacantes emplean tecnologías automatizadas para generar correos de phishing mejor redactados y adaptados a distintos idiomas, y existen casos documentados del uso de técnicas de suplantación de voz en fraudes telefónicos. En este contexto, los enfoques defensivos basados únicamente en reglas estáticas resultan insuficientes por sí solos. Paralelamente, grupos de investigación y empresas de ciberseguridad en Europa exploran el uso de técnicas avanzadas de IA y automatización adaptativa para mejorar la detección y respuesta frente a nuevas variantes de ataque. Asimismo, la adopción de protocolos consolidados de autenticación de correo, como DMARC, junto con la incorporación progresiva de capacidades de análisis avanzado, se perfila como una práctica cada vez más extendida en sectores regulados como la banca y en el ámbito corporativo en general.

Hacia una defensa proactiva y contextual

La batalla contra el fraude BEC ha cambiado de terreno. Ya no se trata solo de proteger los servidores, sino de proteger la confianza en las comunicaciones humanas. La combinación del análisis estilométrico, que detecta la falsificación de la identidad en la forma, con los agentes de razonamiento, que detectan la falsedad en los hechos, representa el salto cualitativo necesario para frenar esta sangría económica.

El impacto de adoptar estas soluciones va más allá del ahorro financiero directo. Preserva la reputación de las empresas y reduce la carga cognitiva de los empleados, quienes hoy viven con el miedo constante a hacer clic en el lugar equivocado. La tecnología está lista para ser ese «copiloto» de seguridad que valida nuestras interacciones digitales.

No podemos pedir a los empleados que sean infalibles ante atacantes que usan inteligencia artificial para engañarlos. Es hora de equipar a nuestros equipos con su propia inteligencia artificial defensiva, una que no solo lea correos, sino que entienda la realidad que los rodea.