Desde un despacho en San Sebastián, una startup que hasta hace poco trabajaba casi en silencio ha dado un golpe sobre la mesa. Multiverse Computing ha presentado CompactifAI, una tecnología que reduce los grandes modelos de lenguaje sin que pierdan capacidad de respuesta. Hasta un 95 % más pequeños. Y lo hace justo donde más se ve, en Amazon Web Services. El objetivo no es competir por tamaño, sino por ligereza. Porque no todo el mundo puede permitirse una inteligencia artificial XXL.

La promesa de las redes tensoriales

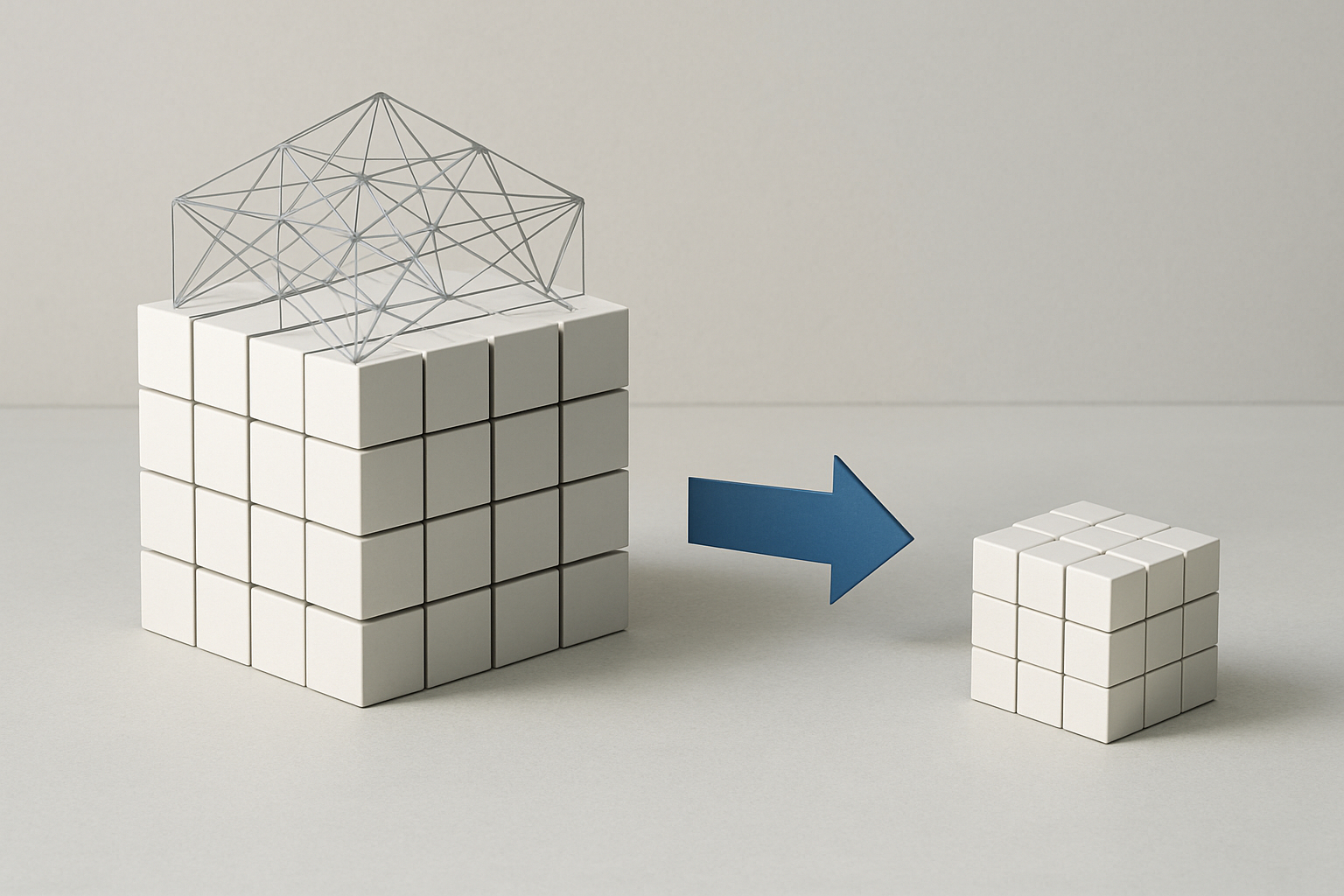

CompactifAI no elimina, reorganiza. Utiliza redes tensoriales —estructuras matemáticas que en física cuántica sirven para describir sistemas complejos— para comprimir los modelos sin borrar información. Es como encajar una colcha en una mochila sin dejar arrugas. En vez de reducir parámetros a ciegas, los redistribuye con precisión. Menos memoria, menos coste, menos espera. Pero con los mismos reflejos. O casi. Según la empresa, el modelo conserva el 99 % de su precisión.

De laboratorio vasco a escaparate global

La API ya se ofrece en AWS, lo que permite ejecutar versiones comprimidas de LLaMA, Mistral o DeepSeek desde cualquier entorno compatible. Sin instalar nada. Sin comprar servidores. Basta con una conexión. Esto significa que pequeñas empresas, administraciones públicas o centros educativos pueden acceder a modelos antes reservados a gigantes. Una IA más repartida, menos elitista. La compresión, en este caso, también es un gesto político.

215 millones, una apuesta que se nota

Multiverse ha conseguido que la teoría se traduzca en confianza. En junio cerró una ronda de financiación Serie B de 189 millones de euros. Inversores como HP Tech Ventures, Toshiba o Bullhound Capital entraron para escalar la tecnología. Pero el respaldo más simbólico vino del Gobierno español con 59,2 millones a través del PERTE Chip, con entrada directa en el accionariado. Una apuesta por la soberanía tecnológica, pero también por mantener talento e infraestructura en casa.

Comprimir también abre grietas

Reducir tamaño sin perder precisión suena bien. Pero la compresión no es mágica. ¿Qué pasa con los matices? ¿Funcionan igual en catalán que en inglés? ¿En contextos técnicos o sanitarios? Las pruebas internas son prometedoras, pero falta validación independiente. Y luego está la otra pregunta, ¿qué pasa cuando cualquier dispositivo puede ejecutar una IA avanzada? ¿Qué controles, qué límites, qué usos?

Una estrategia distinta a la del resto

Mientras OpenAI y Anthropic siguen aumentando el tamaño de sus modelos, Multiverse va en sentido contrario. Donde otros agrandan, ellos afinan. Es una forma de desmarcarse, pero también de adaptarse. No todo el mundo tiene GPUs, y no toda IA necesita correr en centros de datos. Aquí, la compresión es una forma de inclusión. Y su alianza con AWS permite llegar lejos sin depender de infraestructura propia. No es David contra Goliat. Es otra liga.

IA ligera, pero con peso específico

CompactifAI es como un libro de mil páginas en edición de bolsillo. No cambia el contenido, pero cambia quién puede llevarlo encima. ¿Estamos ante una inteligencia artificial que cabe en la palma y actúa con precisión quirúrgica? ¿O ante una nueva fase de expansión sin filtro? Las herramientas están listas. La decisión —como casi siempre— depende de cómo, dónde y para qué se usen.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.