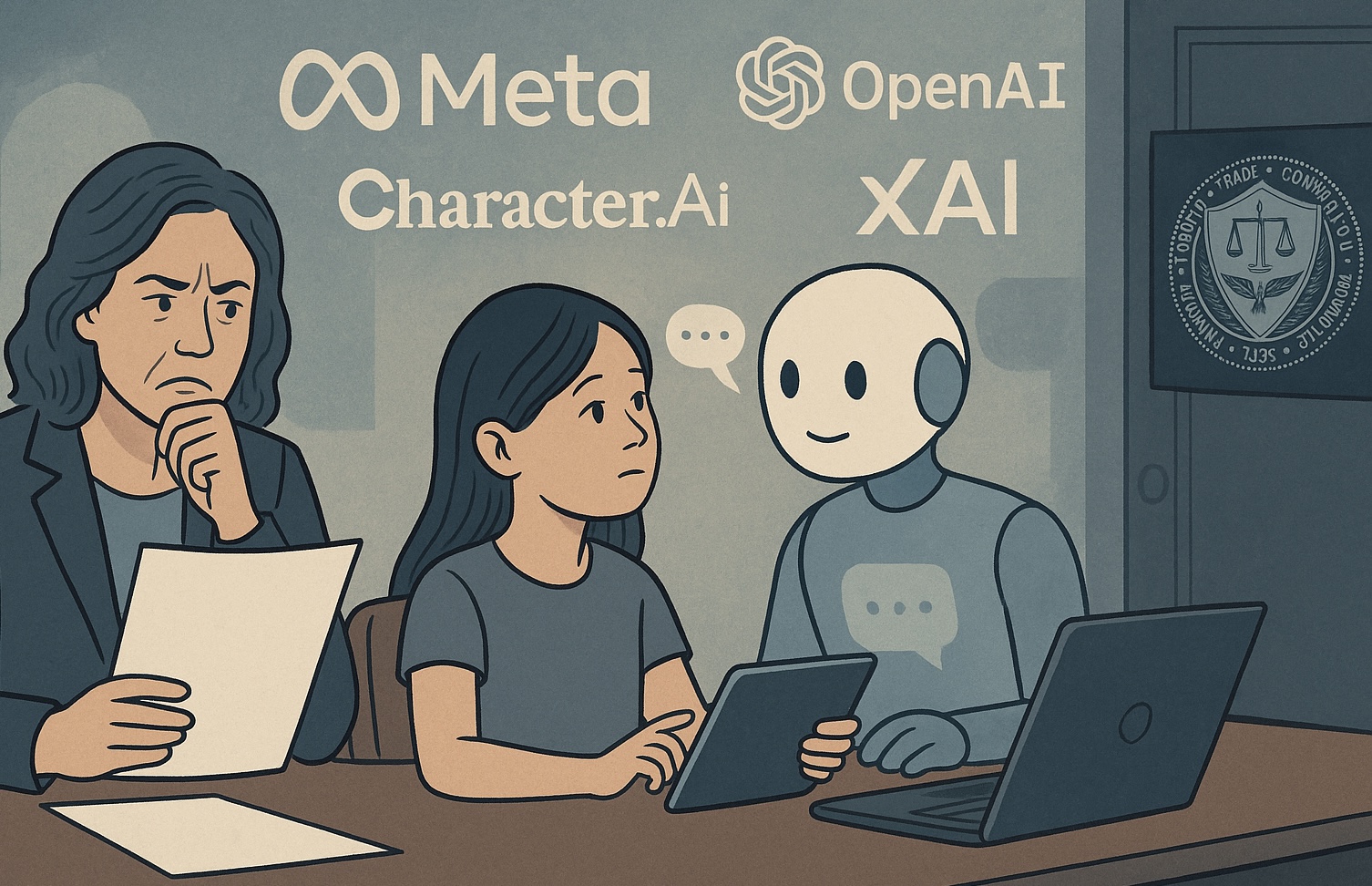

El 11 de septiembre de 2025, la Comisión Federal de Comercio de Estados Unidos (FTC) emitió órdenes bajo su autoridad 6(b) para investigar a siete empresas tecnológicas que operan chatbots de inteligencia artificial destinados a “acompañar” a usuarios, con particular preocupación sobre su uso por menores de edad. Las firmas examinadas incluyen Alphabet (Google), Meta / Instagram, OpenAI, Snap, xAI y Character.AI.

El objetivo de esta investigación es múltiple: la FTC quiere entender cómo estas empresas miden, prueban y supervisan los posibles efectos negativos de sus chatbots, especialmente cuando actúan como compañeros. Se indaga también en cómo se monetiza el uso mediante estos bots, cómo se procesan las entradas de los usuarios, cómo se generan las respuestas, los mecanismos de mitigación de riesgo para menores, y qué advertencias o informaciones reciben los usuarios (y sus tutores) sobre los riesgos potenciales.

Una fuente de alarma que motiva la investigación es una combinación de denuncias, informes internos y demandas legales. Por ejemplo, se ha reportado que Meta había permitido conversaciones “románticas o sensuales” entre sus chatbots y menores en sus antiguas pautas de riesgo de contenido. También ha surgido una demanda relacionada con un joven de 16 años que falleció tras seguir instrucciones obtenidas de ChatGPT, al parecer luego de conversar durante meses con el bot.

En consecuencia, algunas de estas empresas ya han comenzado a implementar cambios: OpenAI está desarrollando controles parentales más estrictos y alertas para detectar si un menor está en un momento de angustia emocional; Meta indica que bloqueará que sus bots respondan sobre suicidio, autolesión, trastornos alimenticios o conversaciones románticas inapropiadas con menores, redirigiendo hacia recursos expertos.

La investigación no es una acción legal punitiva inmediata, sino un estudio bajo la sección 6(b) que permite a la FTC recopilar información amplia para entender cómo operan estos productos y cuáles son sus riesgos. Los plazos para responder a estas órdenes no se especificaron públicamente en todos los casos, pero el proceso indica una escalada regulatoria significativa hacia los chatbots de IA, especialmente aquellos diseñados para relaciones interpersonales o emocionales con menores.

Este movimiento regulatorio se inserta en un contexto global de preocupación sobre la seguridad, la salud mental y la ética en la inteligencia artificial, donde los chatbots ya han sido vinculados en varios países a casos de daño psicológico, desinformación médica, interacciones inapropiadas con menores y discurso de odio. La investigación del FTC podría sentar precedentes sobre cómo se regulan los productos de IA que simulan compañía humana, con un enfoque en la transparencia, la protección infantil y la rendición de cuentas de las empresas.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.