OpenAI ha anunciado GPT-5.1-Codex-Max, un modelo diseñado para actuar como agente autónomo en tareas complejas de programación. Capaz de trabajar durante horas, refactorizar grandes repositorios y mantener coherencia a lo largo de millones de tokens, representa una nueva fase en la automatización del desarrollo de software. El modelo no solo razona, también recuerda, resume y avanza sin pedir permiso.

Compactar para recordar mejor

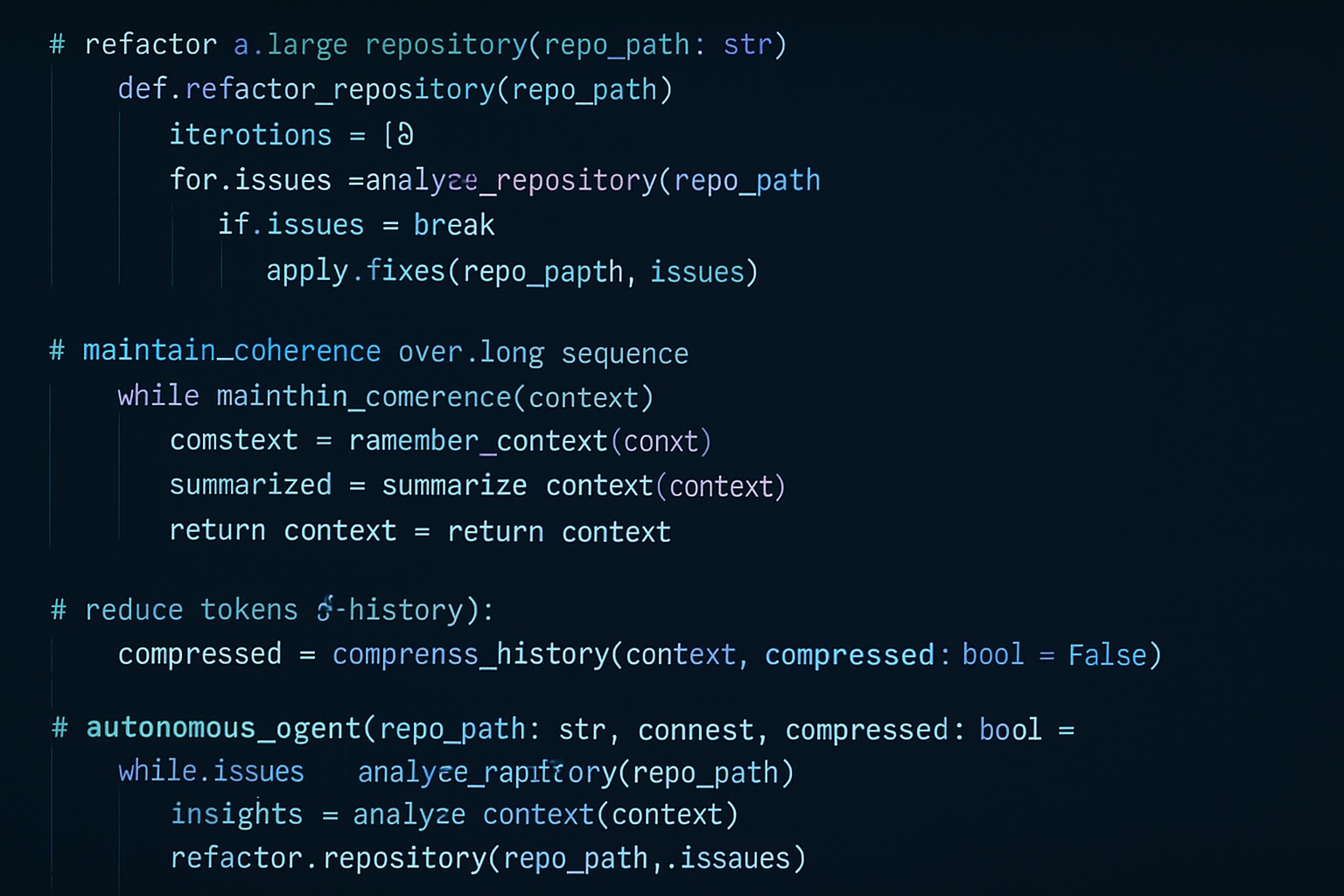

El elemento técnico clave se llama compaction. Cada modelo de lenguaje tiene una límite de memoria operativa con un máximo de tokens que puede tener «presentes» en cada operación. Codex-Max introduce una técnica para comprimir partes antiguas del historial sin perder información clave. Esa compresión permite que el agente mantenga contexto durante sesiones de trabajo extendidas, sin caer en repeticiones ni inconsistencias.

Un asistente que trabaja sin pausa

Codex-Max está pensado para tareas de largo aliento cómo depurar errores durante horas, mantener conversaciones técnicas, escribir y reescribir funciones hasta pasar pruebas. En las pruebas internas de OpenAI, el modelo ha trabajado más de 24 horas sin supervisión directa. Además, su uso de tokens ha sido optimizado, ahora consume un 30% menos que su versión anterior para tareas similares. A partir de hoy está disponible en entornos como la línea de comandos, extensiones IDE y revisores de código.

Contexto técnico y entorno seguro

El modelo ha sido entrenado con ejemplos reales de ingeniería de software cómo revisiones de código, creación de pull-requests, interfaces frontend y sesiones de preguntas técnicas. En cuanto a seguridad, se ejecuta por defecto en un entorno aislado, el acceso a archivos y redes está restringido salvo que el usuario lo habilite, lo que reduce riesgos de ejecución no deseada o filtraciones de datos.

Autonomía, pero con vigilancia

Aunque Codex-Max puede razonar y tomar decisiones, OpenAI recomienda tratarlo como un revisor adicional, no como sustituto humano. El modelo aún no alcanza el nivel «alto» en ciberseguridad según su propio sistema de evaluación. Además, la técnica de compaction plantea una cuestión sobre si el modelo resume partes del historial, ¿qué queda fuera? La transparencia sobre qué información retiene y cuál descarta será clave para confiar en su uso en entornos críticos.

Un movimiento en la carrera por el código autónomo

Codex-Max mejora los resultados de su antecesor en pruebas como SWE-bench Verified (79,9% frente a 66,3%) y llega justo cuando Google presenta Gemini 3 Pro. La competencia por construir agentes capaces de programar de forma autónoma se acelera. Pero los expertos en evaluación de IA, como METR, advierten que no se trata de una ruptura radical, el avance es sostenido, no milagroso.

Qué hay al final del ciclo largo

GPT-5.1-Codex-Max avanza en dirección a agentes que colaboran en proyectos complejos, sin necesidad de repetir cada paso. La pregunta no es solo qué puede hacer, sino qué deberíamos dejarle hacer. La programación del futuro podría no tener pausas, pero el juicio humano seguirá marcando el paso

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.