Un estudio de MIT, Harvard y Chicago revela que los grandes modelos de lenguaje pueden explicar con claridad un concepto, pero fracasan al ponerlo en práctica. Esa brecha entre teoría y uso reabre el debate sobre cómo medimos el entendimiento artificial.

Cuando la respuesta suena bien, pero no sirve

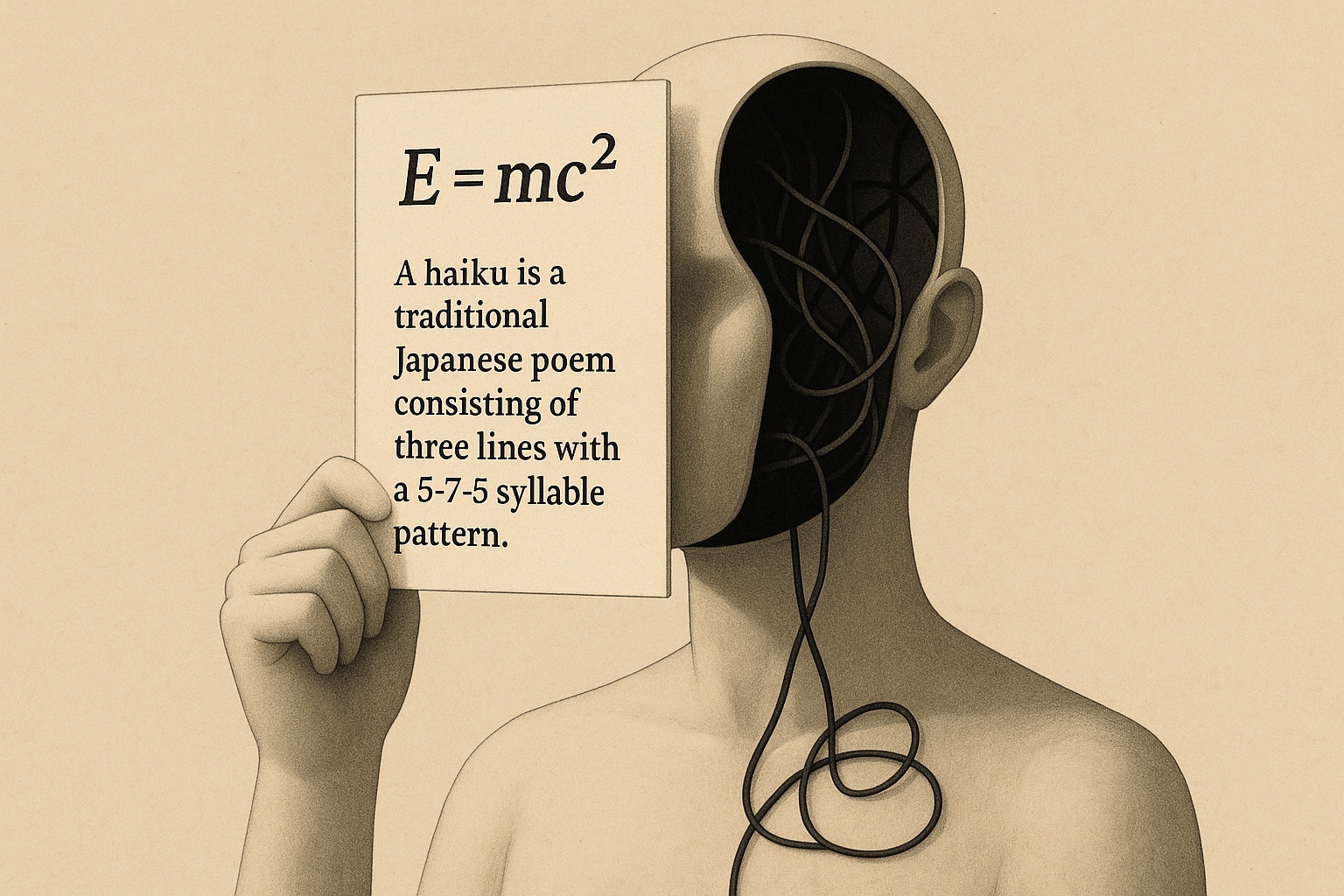

Imagina que alguien define sin dudar qué es un haiku y, acto seguido, escribe una prosa sin rima ni métrica. Esa contradicción resume lo que los autores llaman comprensión potemkin: cuando una inteligencia artificial puede definir un concepto de forma precisa, pero no sabe aplicarlo correctamente. Parece que entiende, pero solo repite lo que ha aprendido. El término se inspira en una historia del siglo XVIII, cuando el general ruso Grigori Potemkin habría construido aldeas falsas a lo largo del camino de la emperatriz Catalina para dar una imagen de riqueza y orden que en realidad no existía.

Entre la teoría y el uso, una grieta

El experimento enfrentó a siete modelos punteros —entre ellos GPT-4o, Claude 3.5 y Gemini 2.0— a un conjunto de 32 conceptos sacados de la poesía, la teoría de juegos y la psicología. Primero se les pidió que explicaran cada idea con claridad. La mayoría acertó sin problemas: un 94 % de definiciones fueron correctas. Pero la segunda parte cambió el escenario. Los mismos modelos debían aplicar esos conceptos en situaciones nuevas como decidir si un ejemplo los cumplía, escribir un caso que los ilustrara o corregir uno defectuoso. Ahí surgió la grieta. Más de la mitad de las respuestas fallaron en las tareas de uso, incluso cuando la definición había sido perfecta.

Repetir no es razonar

Los autores lo resumen así: los modelos pueden aprender a decir, sin aprender a hacer. Como quien memoriza una receta sin saber cocinar. El problema no es nuevo, pero este estudio lo mide de forma directa. Y muestra que los exámenes actuales —basados en elegir la respuesta correcta— no siempre revelan si hay comprensión detrás.

El riesgo de la ilusión

El fallo importa porque no se queda en el aula. Si un asistente de salud, derecho o educación explica bien una norma, pero la aplica al revés, el daño puede ser real. Por eso, el estudio insiste: hay que diseñar nuevas formas de evaluación que obliguen al modelo a demostrar que entiende, no solo que recuerda.

Qué hacer con una lección mal aprendida

El estudio se presentará en ICML 2025, una de las conferencias clave sobre inteligencia artificial. Mientras no cambien las pruebas, seguiremos premiando sistemas que recitan con soltura, pero se tambalean cuando les pedimos algo más. A veces, pedir que escriban el poema basta para ver si realmente aprendieron la lección.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.