Más de 200 voces de peso, entre ellas premios Nobel, investigadores y ex jefes de Estado, han firmado un llamamiento internacional para fijar líneas rojas globales sobre la inteligencia artificial (IA) antes de finales de 2026. La advertencia no se queda en una nota técnica: pide acordar qué usos deben quedar prohibidos de raíz, desde la suplantación de personas hasta la autorreplicación autónoma. La propuesta se plantea como un antídoto frente al riesgo de que los Estados lleguen tarde a regular una tecnología que ya opera a velocidad de vértigo.

Un manifiesto con urgencia incorporada

El texto, titulado Global Call for AI Red Lines, surge de la coalición Red Lines & AI Safety y reclama un acuerdo político internacional que marque límites claros a los sistemas de IA. Fue presentado durante la 80ª sesión de la Asamblea General de Naciones Unidas, lo que otorga al manifiesto una proyección diplomática inmediata. La idea es fijar desde ahora qué usos nunca deberían permitirse, sin importar el país, la empresa o el contexto. Y el calendario también es preciso: los promotores quieren que el consenso esté firmado antes de que termine 2026.

Qué usos quedarían prohibidos

El documento identifica cinco comportamientos extremos de la IA que deberían quedar fuera de la ley: la suplantación de identidad humana, las falsificaciones profundas a gran escala, la autorreplicación de sistemas sin control humano, el despliegue de modelos autónomos en infraestructuras críticas y la intervención armamentística sin supervisión humana. Además, se plantea la creación de una instancia internacional de supervisión, capaz de vigilar el cumplimiento y de responder en caso de incumplimiento. El espíritu de la propuesta se resume en una idea: prevenir antes de lamentar.

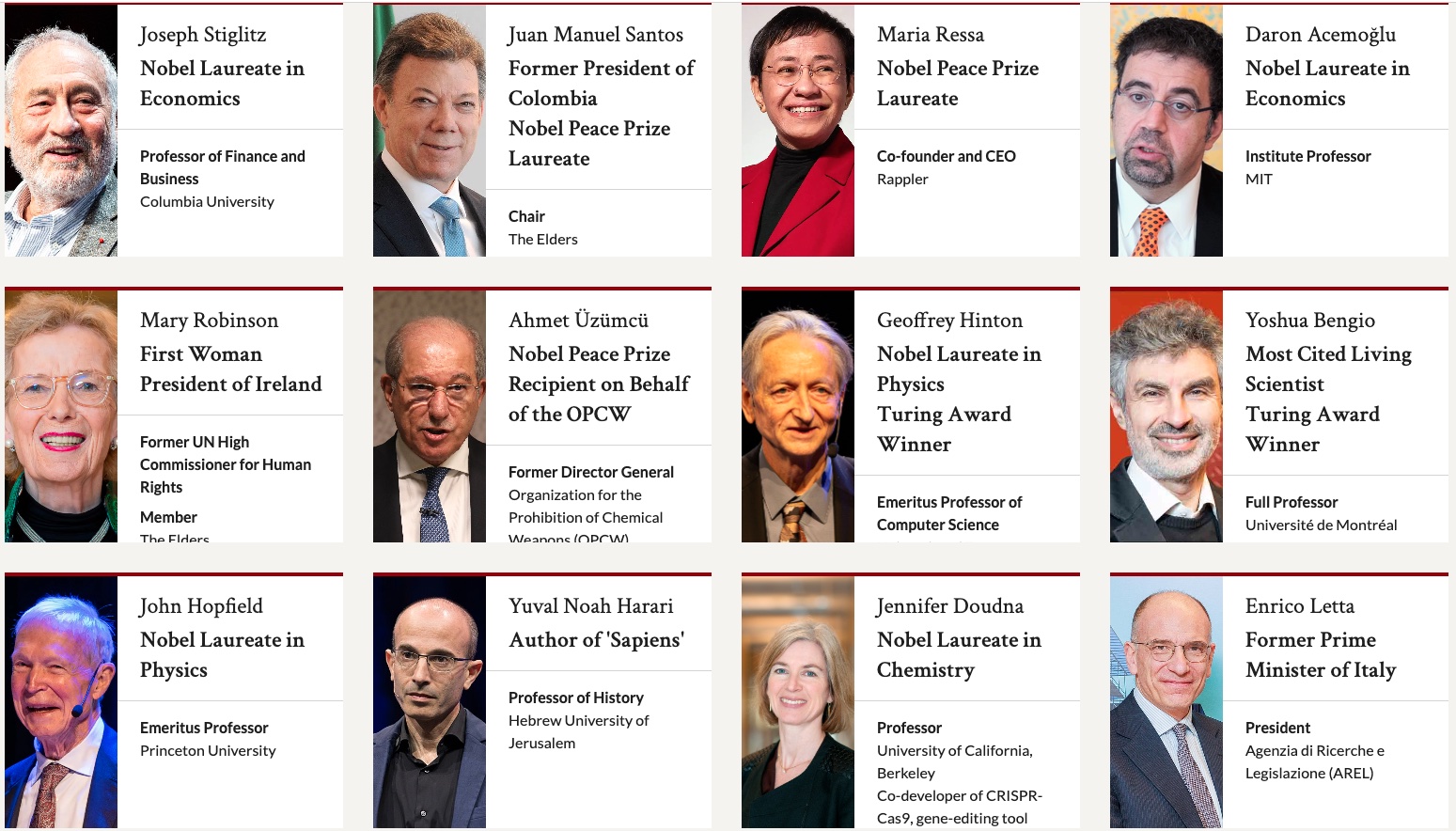

Quién respalda el llamamiento

El documento reúne más de 200 firmas de referencia, desde científicos galardonados con el Nobel, a pioneros de la IA, ex presidentes y primeras ministras, además de representantes de más de 70 organizaciones académicas y de investigación. El abanico de apoyos es inédito en este campo, pues se expande más allá de la comunidad científica de IA e incluye figuras de la economía, los derechos humanos y la diplomacia. La amplitud de apoyos busca dar solidez moral y política al mensaje. El riesgo que todos subrayan es que la IA, en su carrera hacia la sofisticación, sea utilizada como herramienta de manipulación masiva o adquiera dinámicas incontrolables.

Riesgos sin cortafuegos

El Global Call for AI Red Lines advierte que, sin normas internacionales vinculantes, la humanidad enfrentará riesgos crecientes: desde pandemias diseñadas o campañas de desinformación masiva, hasta amenazas a la seguridad global, abusos sistemáticos de derechos humanos y la pérdida de control humano sobre sistemas avanzados. Para sus impulsores, la lección está en los precedentes: acuerdos internacionales que prohibieron el uso de armas biológicas o la clonación humana. La propuesta pretende replicar esa lógica de prohibiciones universales y hacerla efectiva con mecanismos de cumplimiento.

Las grietas de un consenso global

El planteamiento, sin embargo, abre varias preguntas. ¿Cómo definir límites comunes entre países con marcos legales y prioridades tan distintos? Lo que un Estado considera amenaza existencial, otro puede verlo como oportunidad económica. Tampoco es claro quién sancionaría, cómo se vigilaría y qué papel tendrían las grandes tecnológicas, que hoy concentran la mayor capacidad de desarrollo. Y siempre aparece el dilema clásico: cuánto riesgo se está dispuesto a aceptar para no frenar la innovación.

Entre Bruselas, Nueva York y Silicon Valley

La iniciativa se suma a un tablero donde ya se mueven piezas. La Unión Europea ha aprobado su Ley de IA, con categorías de riesgo y exigencias de transparencia, aunque no llega a trazar prohibiciones universales. Naciones Unidas ha iniciado debates sobre gobernanza tecnológica, pero sin plazos vinculantes. En paralelo, centros como el Center for AI Safety en Estados Unidos o CeSIA en Francia llevan tiempo pidiendo barreras éticas globales. La diferencia ahora es la urgencia y el marco temporal concreto de 2026 como horizonte inaplazable.

Un reloj en cuenta atrás

El reclamo de los Nobel deja una imagen clara: un reloj que avanza hacia 2026 mientras los Estados aún discuten quién debe liderar la conversación. El dilema es doble. Si no se pactan líneas rojas, la IA podría avanzar sin cortafuegos. Si se pactan tarde, quizá los sistemas más potentes ya estén en circulación. El tiempo, más que la tecnología, parece ser la verdadera medida del riesgo.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.