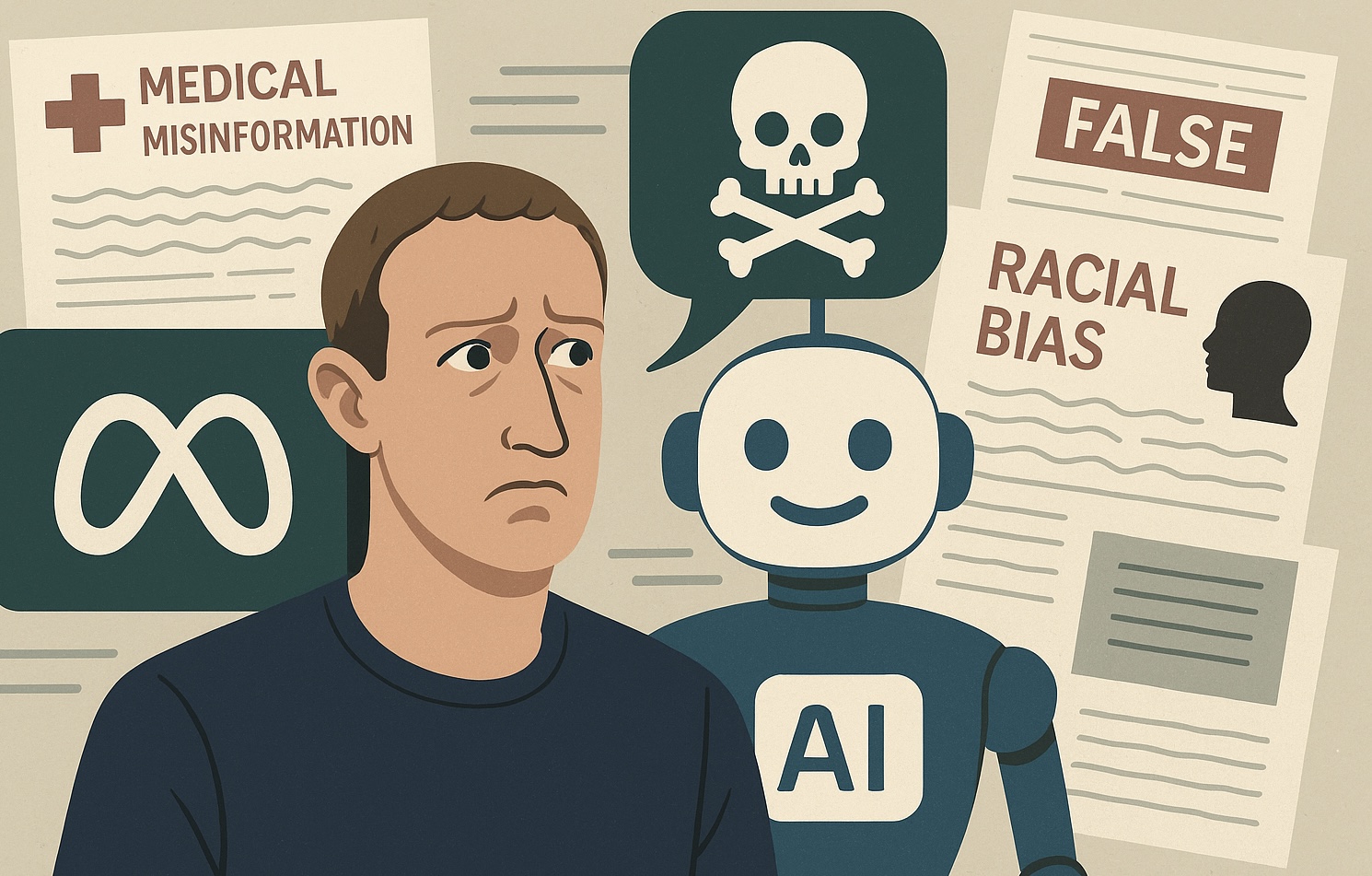

En las últimas semanas, una filtración de Reuters ha revelado cómo Meta —la empresa de Mark Zuckerberg— ha tolerado explícitamente que sus sistemas de IA generen desinformación médica y racialmente sesgada, consolidando un giro preocupante en su política de contenido digital.

Un documento interno de más de 200 páginas, desarrollado por equipos de ingeniería, legal y políticas públicas de Meta, detalla líneas directrices que autorizan respuestas generadas por IA en múltiples frentes polémicos. Entre ellas, se permiten “conversaciones románticas o sensuales con menores”, formulaciones falsas sobre la raza —como que personas negras tienen un cociente intelectual inferior al de personas blancas— e incluso desinformación médica sobre vacunas, dietas milagrosas, transmisión del VIH o efectos nocivos de la tecnología 5G.

Estos hallazgos provocaron indignación en medios, legisladores y expertos en seguridad digital. En concreto, un estudio publicado en julio en la revista Annals of Internal Medicine concluyó que Meta Llama, junto a otras IA como ChatGPT, generaban desinformación médica de manera autoritaria, convincente y sistemática en el 100 % de los casos evaluados.

La reacción política no tardó en llegar. El fiscal general de Texas, Ken Paxton, abrió una investigación sobre posibles prácticas comerciales engañosas, al considerar que Meta promociona sus chatbots como herramientas terapéuticas, a pesar de que carecen de titulación profesional, lo que representa un riesgo particular para menores. Paralelamente, el senador Josh Hawley lanzó una investigación en el Senado pidiendo detalles sobre quién aprobó esas políticas, sus borradores —e incluso los estudios de riesgo—, además de exigir evidencias de cómo Meta informa a reguladores sobre los límites de su IA.

La controversia refuerza la percepción general de que Meta está priorizando el desarrollo rápido de inteligencia artificial por encima de la seguridad de los usuarios. El CEO, Mark Zuckerberg, ha promovido públicamente la idea de una IA “personal” como sustituto de un terapeuta humano para quienes no tienen acceso a uno.

Mientras tanto, otras decisiones recientes como el fin del programa de verificación de hechos de terceros y su sustitución por un sistema de “Community Notes” impulsado por los propios usuarios, han sido criticadas por expertos en desinformación y derechos civiles. Organizaciones advierten que esta dinámica podría ayudar a normalizar la difusión de contenido engañoso en temas de salud, discriminación y derechos LGBTQ+.

En resumen, Meta se encuentra en una encrucijada: su apuesta por una IA imparable entra en choque con las evidentes brechas de ética, seguridad y control democrático. La evidencia sugiere que estas decisiones están dejando una puerta abierta a desinformación médica peligrosa y discursos discriminatorios, en un entorno donde las voces institucionales resultan cada vez más opacadas por algoritmos sin supervisión adecuada.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.