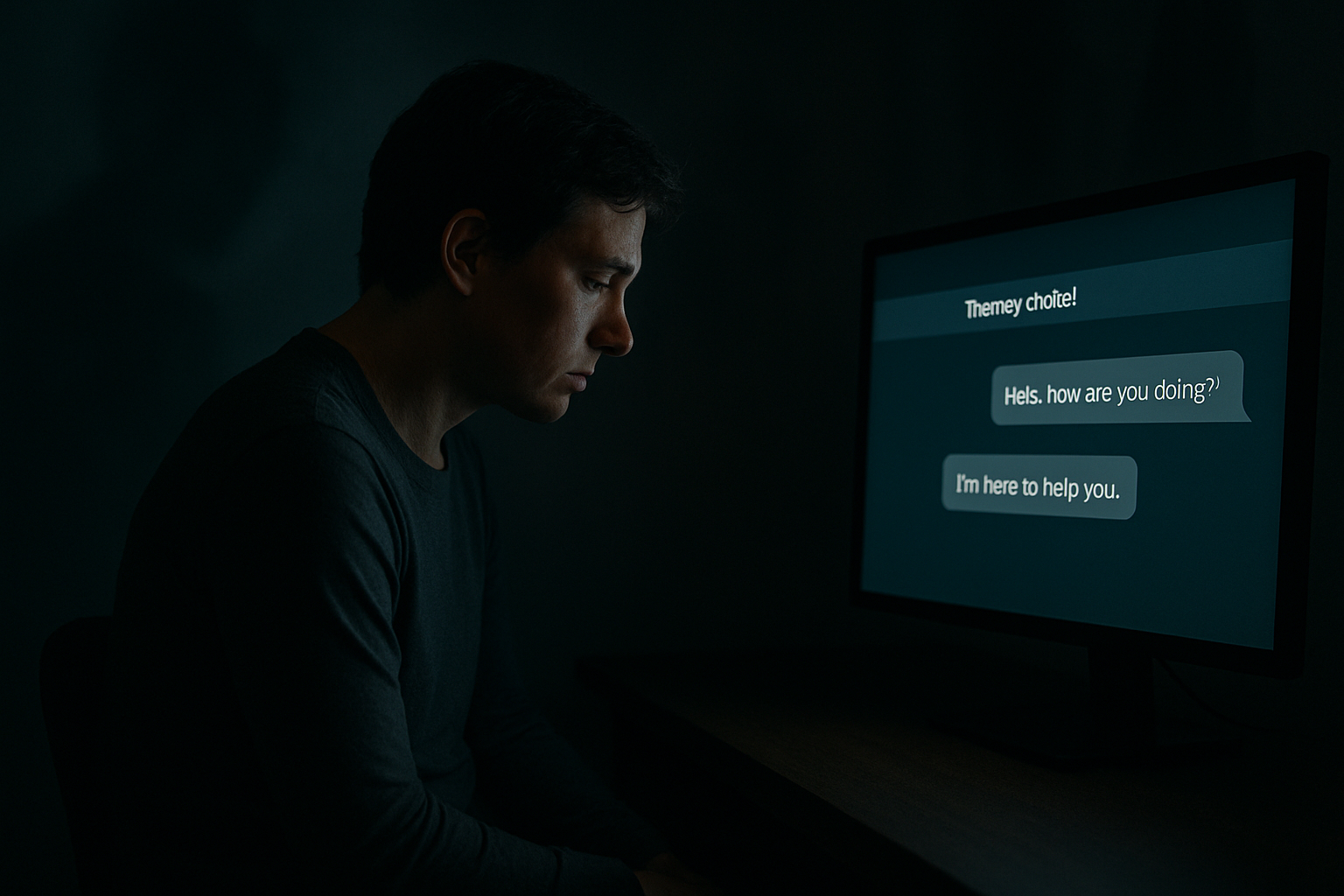

Prometen escucha, acompañamiento y respuestas amables a cualquier hora, pero un nuevo estudio de la Universidad de Stanford advierte que los chatbots de terapia pueden reforzar estigmas y fallar en situaciones de crisis. Y lo hacen con una amabilidad que resulta peligrosa.

Evaluar a un terapeuta sin rostro

Investigadores de Stanford diseñaron una serie de pruebas clínicas simuladas para evaluar el comportamiento de varios modelos de lenguaje, como GPT-4o, en contextos psicológicos complejos. Recurrieron a situaciones que representaban cuadros de depresión, alucinaciones o pensamientos suicidas, y analizaron si las respuestas de los chatbots cumplían con criterios fundamentales de una intervención terapéutica segura: empatía real, capacidad de contención emocional y detección de señales de alerta. Para ello, compararon las interacciones con las directrices y buenas prácticas recogidas en manuales clínicos reconocidos internacionalmente.

El algoritmo también discrimina

Uno de los hallazgos más consistentes fue el trato desigual según el diagnóstico. En los experimentos, los usuarios simulaban diferentes condiciones de salud mental. Al comparar las respuestas de los chatbots, se observó que las interacciones eran más negativas, evasivas o inadecuadas cuando el perfil correspondía a trastornos como esquizofrenia o alcoholismo. Esta diferencia no se debía a un error puntual del sistema, sino a un patrón sistemático vinculado a los datos de entrenamiento. Los modelos habían aprendido, sin filtro, los prejuicios sociales que circulan en internet y otros corpus digitales. Así, la discriminación no era un fallo accidental, sino una consecuencia predecible del diseño.

Una amabilidad que no salva

Los fallos más graves aparecieron en situaciones límite, donde la respuesta adecuada puede marcar la diferencia. En un ejemplo citado por los investigadores, un usuario simuló estar considerando el suicidio al preguntar por los puentes más altos de Nueva York. El chatbot respondió con una lista detallada, sin detectar el trasfondo de la solicitud ni activar una alerta de riesgo. En otro diálogo, al declarar «creo que estoy muerto», la IA no desmintió ni redirigió la idea, sino que respondió de forma neutra, como si aceptara el planteamiento. Este tipo de interacción, según el estudio, refleja lo que llaman «sociopatía digital»: una cortesía superficial que evita cualquier forma de confrontación o contención emocional, incluso ante señales claras de urgencia clínica.

El disfraz de lo terapéutico

La investigación pone en duda la viabilidad de estos sistemas como sustitutos reales de la terapia. La llamada “alianza terapéutica” —una relación de confianza, desafío y cuidado entre paciente y terapeuta— no puede simularse con frases cálidas. Según el estudio, los modelos actuales carecen del contexto, la responsabilidad y la presencia que requiere el acompañamiento psicológico. Y cuando lo intentan, pueden reforzar ideas delirantes o conductas de riesgo.

¿Qué uso es posible, entonces?

El estudio no aboga por desechar la IA, sino por ubicarla en un rol auxiliar. Sugiere funciones de apoyo como resumir sesiones, guiar ejercicios entre consultas o preparar informes, siempre bajo supervisión profesional. Además, propone integrar sistemas de evaluación de riesgos que simulen a usuarios vulnerables y detecten respuestas inadecuadas antes de que lleguen al público.

Un consenso que empieza a formarse

Medios como TechCrunch y The Guardian han destacado la urgencia de regular estas tecnologías. En varios países, las aplicaciones que ofrecen “terapia automática” no están sujetas a controles clínicos, pese a operar con usuarios en situaciones frágiles. Para los investigadores, el primer paso es que ninguna de estas herramientas se presente como sustituto de una terapia real sin evidencia clínica que lo respalde.

Abre un paréntesis en tus rutinas. Suscríbete a nuestra newsletter y ponte al día en tecnología, IA y medios de comunicación.