Uno de los problemas con los que nos encontramos los periodistas en esta era dominada por la creación de imágenes con IA es detectar la veracidad de los contenidos. Desde que existe la fotografía que se han usado diferentes técnicas para editar la realidad. Ya en la Unión Soviética, Stalin mandaba retocar fotografías para borrar a sujetos que con el tiempo se habían convertido en enemigos.

Con la aparición de Photoshop hubo una primera liberalización: de repente la edición fotográfica estaba al alcance de cualquier usuario que contara con un ordenador personal. Ahora, con la IA generativa, ya existen aplicaciones que crean imágenes falsas en segundos a partir de un prompt directamente desde el smartphone.

Este cambio cuantitativo supone una ventana de oportunidad para los actores desinformadores, que lo tienen más fácil que nunca para generar bulos. No importa lo trabajados que estén los prompts si al final las redes sociales quedan inundadas con ‘deepfakes’, ya que aquí se trata de minar la credibilidad de los ciudadanos en la realidad y, además, atacar a las instituciones democráticas.

Is it AI?

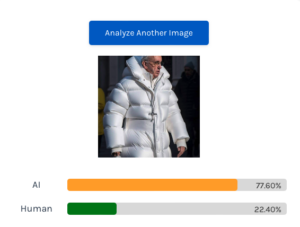

Esta imagen del Papa Francisco ha sido generada con IA.

En este esfuerzo por dar herramientas que permitan al usuario contrastar si una imagen ha estado generada con Inteligencia Artificial, surge la aplicación ‘Is it AI?’. Su uso es muy sencillo: basta con introducir una imagen de la que tenemos serias dudas sobre su procedencia. El algoritmo ha estado entrenado con miles de fotografías que se han ido etiquetando como ‘humans’ o ‘generadas con IA’.

La idea es que, a partir de un input, sea capaz de predecir las probabilidades de que una parte de la fotografía (o toda ella) haya sido generada con Inteligencia Artificial.

Los límites del modelo

El problema principal de estas herramientas es que pueden quedar desactualizadas en cuestión de semanas. La generación con IA va siempre un paso por delante de los verificadores. Por este motivo, a medida que surgen nuevos algoritmos, se debe continuar entrenando el modelo de detección.

Además, muchas veces los ‘deepfakes’ incluyen audio clonado, lo que añade dificultad a la verificación: descubrir si la voz es real o ha sido generada con un algoritmo. En este sentido, Meta es la compañía que más esfuerzos está poniendo en desarrollar un modelo propio para etiquetar los contenidos generados con IA. Solo el futuro dirá si realmente es efectivo o si, en cambio, esta carrera por ‘cazar’ el fake no tendrá final.